Unidad 1 Conceptos básicos

En esta unidad repasamos los conceptos básicos de probabilidad relacionados con las variables aleatorias y las distribuciones de probabilidad. Presentamos las distribuciones de probabilidad más relevantes, discretas y continuas, y otras no estandarizadas, junto con varios algoritmos y funciones de R útiles para simularlas y realizar cálculos de probabilidad. Resolvemos por simulación múltiples problemas basados en los diferentes tipos de variables presentadas. Por último, introducimos la definición de proceso estocástico, con diversos ejemplos, con el fin de preparar el camino para las unidades siguientes, que ya estarán enfocadas en estudiar en profundidad diferentes tipos de procesos estocásticos. Proponemos al final de la unidad más ejercicios y estudios de caso, para que el alumnado practique los conceptos y algoritmos estudiados.

1.1 Variables aleatorias

Introducimos una serie de conceptos básicos.

Definición 1.1 Una variable aleatoria es una función que asigna un número real a cada uno de los posibles resultados de un experimento o característica de interés susceptibles de ser observados o medidos en una población objetivo.

Las variables aleatorias pueden ser discretas o continuas en función de sus posibles valores. Si los valores o resultados posibles se pueden contar (sin ser infinitos), se dice que la variable aleatoria es ‘discreta’; en caso contrario, se dice que es ‘continua.’ Veamos varios ejemplos.

Ejemplo 1.1 Un proveedor vende huevos por cajas que contienen 144 huevos. El proveedor desea estudiar el número de huevos que se suelen romper en cada una de las cajas durante el proceso de distribución. Es de interés pues, la variable aleatoria \(N\) que contabiliza el número de huevos rotos en una caja, y cuyos valores posibles son \(0, 1, 2,..., 144\). Se trata por tanto de una variable de tipo discreto.

Ejemplo 1.2 Se desea realizar un estudio para estimar la estatura de los habitantes de una ciudad. Se define la variable aleatoria \(X\) como la altura en cm de cada uno de los habitantes de la ciudad. Dado que los posibles resultados son infinitos, diremos que dicha variable es de tipo continuo.

Definición 1.2 Se define el espacio probabilístico \(S\) asociado a una variable aleatoria como el conjunto de todos los valores posibles o con probabilidad que puede tomar dicha variable.

1.1.1 Función de probabilidad

Para caracterizar completamente cualquier variable aleatoria es necesario definir la función de distribución, que nos da la probabilidad acumulada por debajo de un valor plausible en el espacio probabilístico \(S\) en el que está definida dicha variable.

Definición 1.3 La función de distribución para una variable \(X\) en un punto \(a\) del espacio probabilístico \(S\) se define como la probabilidad acumulada por debajo de dicho valor:

\[\begin{equation*} F(a) = P(X \leq a). \end{equation*}\]

En el caso de variables aleatorias de tipo discreto podemos caracterizar su comportamiento mediante las probabilidades asociadas a cada uno de los elementos del espacio probabilístico Esto se hace a través de la ‘función puntual de probabilidad’ o ‘función de masa de probabilidad.’

Definición 1.4 La función de masa de probabilidad (fmp) para una variable discreta \(X\) en un punto \(a\) del espacio probabilístico \(S\) se define como la probabilidad de que la variable \(X\) tome dicho valor:

\[\begin{equation*} f(a) = P(X = a). \end{equation*}\]

En el caso de variables aleatorias de tipo discreto, la función de distribución de probabilidad se puede obtener a partir de la función de masa de probabilidad como:

\[\begin{equation*} F(a) = \sum_{k \leq a} f(k) = 1 - \sum_{k > a} f(k). \end{equation*}\]

para cualquier valor de \(a\) en \(S\).

Sim embargo, en las variables aleatorias de tipo continuo no es posible asignar una probabilidad a cada uno de los infinitos valores de la variable, dado que en ese caso la probabilidad del espacio probabilístico íntegro excedería el valor 1 y por lo tanto no sería una probabilidad. En estas variables es preciso definir otra función que permita cuantificar cualquier situación que involucre los resultados del espacio probabilístico \(S\) asociado a la variable aleatoria. Surge la ‘función de densidad de probabilidad.’

Definición 1.5 La función de densidad de probabilidad (fdp), \(f\), asociada a una variable \(X\) de tipo continuo permite calcular la probabilidad acumulada en un intervalo cualesquiera \((a,b]\) del espacio probabilístico \(S\) a través de la integral en dicho intervalo:

\[\begin{equation*} \int_{a}^{b} f(s)ds = Pr(a < X \leq b) = F(b) - F(a). \end{equation*}\]

De esta forma la ‘función de distribución’ de una variable continua se puede obtener como:

\[\begin{equation*} F(a) = \int_{r_{min}}^{a} f(s)ds. \end{equation*}\]

donde \(r_{min}\) es el valor mínimo de \(X\) en el espacio probabilístico \(S\).

1.1.2 Variables relevantes

Hay muchas funciones de distribución que se utilizan con tanta frecuencia que se conocen con nombres especiales, y que presentamos en las Secciones Distribuciones Discretas y Distribuciones continuas. Para estas variables resulta bastante sencillo realizar cualquier calculo de probabilidad, ya que la mayoría de programas informáticos tienen implementadas sus funciones de distribución. Utilizaremos no obstante la simulación para realizar cálculos probabilísticos.

En \(R\) se puede acceder directamente a la función de densidad, función de distribución, quantiles y simulación de valores de cualquiera de las distribuciones que presentamos a continuación mediante las funciones:

- \(dXXXX(par)\): función de densidad,

- \(pXXXX(par)\): función de distribución,

- \(qXXXX(par)\): quantiles,

- \(rXXXX(par)\): generación de valores de la variable,

donde \(XXXX\) identifica la distribución/variable de interés y \(par\) son los parámetros que la caracterizan.

1.1.3 Media y varianza

Muchas variables aleatorias tienen funciones de distribución complicadas y, por tanto, es difícil obtener una comprensión intuitiva del comportamiento de la variable conociendo simplemente la función de distribución. Dos medidas, la media o valor esperado y la varianza se definen para ayudar a describir el comportamiento de una variable aleatoria. El valor esperado equivale a la media aritmética de infinitas observaciones de la variable aleatoria y la varianza es una indicación de la variabilidad o dispersión de los valores de dicha variable.

Definición 1.6 Dada una variable aleatoria \(X\) discreta sobre un espacio probabilístico \(S\), se define el valor esperado o esperanza de \(X\), \(E(X)\), como

\[E(X) = \sum_{k \ in S} kf(k)\]

donde \(f\) es la fmp de \(X\).

Cuando \(X\) es una variable aleatoria continua, su valor esperado se define a partir de la fdp de \(X\):

\[E(X) = \int_S xf(x)dx.\]

Esta definición se puede aplicar a cualquier función o transformación de una variable aleatoria, \(h(X)\), para obtener su valor esperado \(E[h(X)]\), y así por ejemplo en el caso continuo tendríamos:

\[E[h(X)]=\int_S h(x)f(x)dx.\]

El valor esperado nos da una medida de localización para la variable aleatoria \(X\), pero es bien sabido que dichas medidas de localización se deben acompañar siempre de una medida de dispersión, como la varianza o desviación típica.

Definición 1.7 Dada una variable aleatoria \(X\) con valor esperado \(E(X)\) se define la varianza de \(X\), \(V(X)\) como:

\[V(X) = E[(X-E(X))^2]=E(X^2) - E(X)^2\]A partir de la varianza se define la desviación típica de la variable \(X\) como la raíz cuadrada de su varianza. Las propiedades siguientes se derivan directamente a partir de la definición de esperanza y varianza:

Si \(X\) e \(Y\) son dos variables aleatorias y \(c\) una constante, entonces:

- \(E(c) = c\)

- \(E(cX) = cE(X)\)

- \(E(X+Y) = E(X) + E(Y)\)

- \(V(cX) = c^2 V(X)\)

1.2 Aproximación Monte Carlo

Cuando trabajamos con variables aleatorias, es común el problema de querer estimar el valor esperado de cualquier cantidad \(h(X)\), siendo \(X\) una variable aleatoria. Utilizando la simulación es posible obtener estimaciones de dichos valores de un modo relativamente sencillo: a través de la integración Monte Carlo.

Ante un problema genérico relativo a calcular el valor esperado de cierta función \(h(X)\) para una variable aleatoria con fdp \(X \sim f(x)\),

\[\begin{equation} E[h(X)]=\int_S h(x) f(x) dx \tag{1.1} \end{equation}\]

donde \(S\) denota el conjunto en el que la variable \(X\) toma valores,

Definición 1.8 Ante el problema de estimar (1.1), el procedimiento de estimación Monte Carlo propone simular una muestra aleatoria de la distribución de \(X\), \(x_1,\ldots,x_n\) y con ella obtener una aproximación empírica a través del promedio de las cantidades \(h(x_1),\ldots,h(x_n)\),

\[\begin{equation} \bar{h_n}=\frac{\sum_{i=1}^n h(x_i)}{n}. \tag{1.2} \end{equation}\]

Por la Ley de los Grandes Números, \(\bar{h_n}\) converge casi seguro a la cantidad de interés \(E[h(X)]\). Además, cuando \(h^2(X)\) tiene un valor esperado finito, la velocidad de convergencia de \(\bar{h_n}\) se puede calcular y la varianza asintótica de la aproximación es \[Var(\bar{h_n})=\frac{1}{n} \int_S (h(x)-E[h(X)])^2 f(x) dx,\] que se puede estimar con la muestra \(x_1,\ldots,x_n\) a través de

\[\begin{equation} v_n=\frac{1}{n^2} \sum_{i=1}^n [h(x_i)-\bar{h_n}]^2. \tag{1.3} \end{equation}\]

Más específicamente, por el Teorema Central del Límite, para \(n\) grande tendremos que

\[\begin{equation} \frac{\bar{h_n}-E[h(X)]}{\sqrt{v_n}} \sim N(0,1), \tag{1.4} \end{equation}\]

lo que permitirá además, construir bandas de confianza para la aproximación Monte Carlo, a la que en adelante nos referiremos por “aproximación MC.”

\[\begin{equation} IC_{1-\alpha}[\bar{h_n}]=[\bar{h_n}-z_{1-\alpha/2} \sqrt{v_n}, \bar{h_n}+z_{1-\alpha/2} \sqrt{v_n}] \tag{1.5} \end{equation}\]

donde \(z_{1-\alpha/2}\) es el cuantil \(1-\alpha/2\) de una normal estándar, asociado al nivel de confianza \(1-\alpha\).

1.2.1 MC y probabilidad

Aunque en las situaciones más sencillas se puede evaluar cualquier probabilidad mediante la correspondiente función de distribución, en muchas ocasiones resulta sencillo obtener una muestra simulada de la variable aleatoria y aproximar dicha probabilidad de interés mediante el denominado estimador Monte-Carlo.

Se obtiene la estimación Monte-Carlo (MC) de la probabilidad de que una variable aleatoria \(X\) tome algún valor en un conjunto \(A\) de valores dentro de su espacio probabilístico, \(Pr(X \in A)\), a partir de un conjunto de observaciones o simulaciones \(x_1, x_2,...,x_N\) de la variable \(X\), mediante el cociente entre el número de simulaciones que están en dicha región \(A\), y el número de datos disponibles,

\[\begin{equation} Pr(X \in A) \approx \frac{\#\{x_1, x_2,...,x_N\} \in A}{N}. \end{equation}\]

Básicamente esta definición se fundamenta en la interpretación empírica de la probabilidad, a través del ratio de casos favorables por casos posibles:

\[probabilidad=\frac{\mbox{casos favorables}}{\mbox{casos posibles}}.\]

La fórmula anterior la podemos expresar en notación similar a la utilizada en (1.2) definiendo una variable dicotómica \[I_A(X)=1 \text{, si } X \in A\] y 0 en otro caso, de manera que el problema de calcular una probabilidad según una distribución de probabilidad para \(X\) se convierte en el valor esperado de una distribución Bernouilli para una distribución de

\[Pr(X \in A)=\int_A f(x)dx=\int_S I_A(X)f(x)dx=E[I_A(X)]\] y la estimación MC (1.2) se puede expresar, para un conjunto de \(n\) simulaciones \(x_1,\ldots,x_n\), como

\[\begin{equation} Pr(X \in A)\approx \hat{h_n}= \frac{\sum_{i=1}^n I_A(x_i)}{n}, \tag{1.6} \end{equation}\]

y su varianza con

\[\begin{equation} v_n=\frac{1}{n^2} \sum_{i=1}^n [I_A(x_i)-\bar{h_n}]^2. \tag{1.7} \end{equation}\]

Ejemplo 1.3 En la situación del ejemplo 1.1, supongamos que disponemos de un conjunto de 200 simulaciones del número de huevos defectuosos en 200 cajas distribuídas. Queremos descubrir, utilizando exclusivamente esas simulaciones:

- La probabilidad de que una caja tenga más de 3 huevos defectuosos, \(Pr(X>3)\).

- La probabilidad de que una caja tenga a lo sumo 3 huevos defectuosos, \(Pr(X\leq 3)\).

- La probabilidad de que una caja no tenga ningún huevo defectuoso, \(Pr(X=0)\).

- La probabilidad de que la proporción de huevos defectuosos en una caja sea inferior al 1%, \(Pr(X/144 < 0.01)=Pr(X<1.44)\).

# Simulaciones disponibles

defectos <- c(2, 2, 0, 0, 0, 2, 1, 2, 1, 4, 1, 0, 0, 2, 4,

0, 0, 0, 0, 1, 1, 1, 2, 2, 3, 1, 0, 4, 3, 1, 0,

2, 2, 2, 3, 1, 0, 2, 2, 2, 3, 1, 0, 1, 0, 1, 2,

0, 0, 2, 3, 2, 3, 2, 4, 4, 0, 1, 1, 3, 0, 0, 3,

2, 0, 0, 0, 3, 0, 1, 4, 1, 1, 2, 1, 1, 4, 1, 1,

1, 0, 1, 0, 1, 2, 2, 1, 3, 1, 2, 1, 2, 3, 1, 2,

5, 1, 1, 1, 1, 0, 1, 1, 1, 2, 1, 0, 0, 1, 2, 2,

1, 1, 1, 1, 0, 3, 1, 1, 1, 1, 4, 4, 0, 6, 6, 1,

1, 1, 0, 2, 3, 1, 0, 0, 2, 0, 2, 1, 1, 1, 2, 1,

1, 1, 1, 2, 5, 0, 1, 3, 1, 1, 4, 1, 2, 1, 1, 0,

2, 1, 2, 1, 3, 3, 2, 0, 3, 0, 1, 3, 0, 1, 2, 0,

1, 0, 0, 2, 2, 1, 2, 0, 0, 0, 1, 1, 2, 3, 1, 0,

1, 0, 1, 1, 1, 1, 1, 5, 3)

# Número de simulaciones/observaciones

nsim=length(defectos)

# Tamaño de la caja

tamaño <- rep(144,200)

# Conjunto de datos

huevos <- data.frame(tamaño, defectos)Y vamos aproximando por Monte-Carlo las probabilidades de interés, estableciendo las condiciones lógicas en cada situación.

# Pr(X > 3)

sel <- dplyr::filter(huevos, defectos >3)

prob <- nrow(sel)/nsim

cat("Probabilidad estimada [Pr(X > 3)]: ", prob)## Probabilidad estimada [Pr(X > 3)]: 0.075

# Pr(X <= 3)

sel <- dplyr::filter(huevos, defectos <= 3)

prob <- nrow(sel)/nsim

cat("Probabilidad estimada [Pr(X <= 3)]: ", prob)## Probabilidad estimada [Pr(X <= 3)]: 0.925

# Pr(X = 0)

sel <- dplyr::filter(huevos, defectos == 0)

prob <- nrow(sel)/nsim

cat("Probabilidad estimada [Pr(X = 0): ", prob)## Probabilidad estimada [Pr(X = 0): 0.235

# Pr(X/144 <=0.01)

sel <- dplyr::filter(huevos, defectos <= (0.01*144))

prob <- nrow(sel)/nsim

cat("Probabilidad estimada [Pr(X/144 <=0.01): ", prob)## Probabilidad estimada [Pr(X/144 <=0.01): 0.62El error asociado a la estimación de la probabilidad anterior, lo calculamos aplicando (1.7), y también el intervalo de confianza al 95% con (1.5).

## prob.estim= 0.62## Error Estimado= 0.034

# límites del IC redondeados a 3 cifras decimales

ic.low=round(prob-qnorm(0.975)*error,3)

ic.up=round(prob+qnorm(0.975)*error,3)

cat("IC(95%)[AproxMC(prob.estim)]=[",ic.low,",",ic.up,"]")## IC(95%)[AproxMC(prob.estim)]=[ 0.553 , 0.687 ]De esta forma resultará posible estimar cualquier probabilidad asociada a una variable aleatoria, aun desconociendo su función de distribución o de probabilidad, siempre que dispongamos de una muestra simulada, y esta estimación será más precisa cuanto mayor sea el tamaño de dicha muestra.

1.2.2 MC y momentos

Si disponemos de una muestra (de observaciones o simulaciones) lo suficientemente grande de la variable aleatoria \(X\) podemos aproximar -de modo razonablemente preciso- el valor esperado y la varianza (o desviación típica) sin más que calcular la media y varianza de los datos que componen la muestra.

La precisión de estas estimaciones estará directamente relacionada con el tamaño de la muestra utilizada.

Sean \(x_1, x_2,...,x_N\) simulaciones disponibles para \(X\). Entonces

\[\begin{eqnarray*} E(X) &\approx& \bar{x}_N=\sum_{i=1}^N x_i /N \\ Var(X) &\approx& \sum_{i=1}^N (x_i-\bar{x}_N)^2/n = \bar{x}_N^2-\sum_{i=1}^N x_i^2 /N. \end{eqnarray*}\]

Ejemplo 1.4 Con los datos del ejemplo anterior, queremos saber cuál es el número aproximado de huevos que se rompen en cada caja, conocer su dispersión y tener así mismo un intervalo de confianza para la media.

# media

media=mean(huevos$defectos)

# dispersión

varianza=var(huevos$defectos)

desvtip=sd(huevos$defectos)

# ic para la media

error=sqrt(sum((huevos$defectos-media)^2)/(nsim^2))

cat("\n Error Estimado (media)=",round(error,3))##

## Error Estimado (media)= 0.089

# límites del IC redondeados a 3 cifras decimales

ic.low=round(media-qnorm(0.975)*error,3)

ic.up=round(media+qnorm(0.975)*error,3)

cat("IC(95%)[AproxMC(media)]=[",ic.low,",",ic.up,"]")## IC(95%)[AproxMC(media)]=[ 1.255 , 1.605 ]1.3 Distribuciones discretas

Destacamos como principales variables de tipo discreto las siguientes: Bernouilli, Binomial, Geométrica y Poisson.

1.3.1 Bernouilli

Imaginemos una situación experimental donde el resultado de cierta variable que observamos únicamente puede tomar dos valores posibles, denominados “éxito” (codificado con el valor 1) y “fracaso” (codificado con el valor 0). Así pues, la variable aleatoria asociada \(X\) verifica que:

\[\begin{equation} Pr(X = x) = \begin{cases} \theta & \text{ si } x = 1 (\text{ éxito})\\ 1- \theta & \text{ si } x = 0 (\text{ fracaso.}) \end{cases} \tag{1.8} \end{equation}\]

Definición 1.9 Una variable aleatoria \(X\) cuya fmp viene dada por (1.8) se denomina variable Bernouilli, con probabilidad de éxito \(\theta\), y se denota por:

\[X \sim Ber(\theta)\]

de forma que \(E(X) = \theta\) y \(V(X) = \theta(1-\theta).\)

Un ejemplo típico de una variable Bernouilli es el lanzamiento de una moneda que sólo tiene dos posibles resultados: cara o cruz. Si la moneda esta equilibrada tenemos que \(\theta = 0.5\) (idéntica probabilidad para cualquiera de los dos resultados), de forma que si definimos por ejemplo el éxito por conseguir cara, tendremos:

\[X = \text{ Obtener cara } \sim Ber(0.5)\]

Una distribución \(Ber(p)\) es equivalente a una distribución binomial con parámetros 1 y p, \(Bin(1,p)\), de modo que para simular y realizar cálculos de probabilidad con ella utilizaremos las funciones correspondientes a la distribución binomial que vemos a continuación.

- La función

dbinom(x,1,prob)nos permite evaluar la \(Pr(X=x)\) para una variable Bernoilli con probabilidad de éxitoprob. - La función

pbinom(x,1,prob)nos permite evaluar la \(Pr(X \leq x), x=0,1\). - La función

rbinom(n,1,prob)permite simular \(n\) valores Bernouilli.

1.3.2 Binomial

Consideramos un experimento Bernouilli que repetimos en \(n\) ocasiones, obteniendo en cada repetición sólo dos resultados posibles, “éxito” o “fracaso,” con cierta probabilidad \(\theta\) para el éxito, y contabilizamos el número de éxitos \(N\). Los posibles resultados de este experimento son \(\{0, 1, 2,...,n\}\) éxitos conseguidos en un total de \(n\) pruebas. La probabilidad de observar \(x\) éxitos en \(n\) pruebas viene dada por la función:

\[\begin{equation} Pr(N = x) = \frac{n!}{x!(n-x)!} \theta^{x} (1-\theta)^{n-x} \text{ para } x = 0, 1,\ldots,n, \tag{1.9} \end{equation}\]

con \(n\) el número de repeticiones o pruebas Bernouilli realizadas, \(x\) el número de éxitos obtenidos, y \(\theta\) la probabilidad de éxito.

Definición 1.10 La variable aleatoria \(N\) que se obtiene como la suma de \(n\) variables Bernouilli independientes con la misma probabilidad de éxito \(\theta\), y cuya función de masa de probabilidad viene dada en (1.9), se denomina variable Binomial de tamaño \(n\) y probabilidad de éxito \(\theta\), y se denota por:

\[N \sim Bi(n,\theta)\]

con \(E(N) = n\theta\) y \(V(N) = n\theta(1-\theta).\)

A continuación se presentan algunos ejemplos de aplicación de la variable Binomial donde representamos tanto la fmp como la función de distribución asociada al problema de interés. Antes mencionamos las funciones de R relacionadas con esta distribución.

- La función

dbinom(x,size,prob)nos permite evaluar la \(Pr(N=x)\) para una variable Binomial con tamañosizey probabilidad de éxitoprob. -

pbinom(x,size,prob)permite evaluar la \(Pr(N \leq x)\). -

rbinom(n,size,prob)permite simular \(n\) valores de una variable Binomial de tamañosizey probabilidad de éxito \(prob\).

Ejemplo 1.5 Estamos revisando en una empresa el comportamiento de las bajas laborales. En base al histórico, se tiene que cada día aproximadamente el 3% de los trabajadores faltan al trabajo alegando una baja laboral. Si el número de trabajadores de la empresa es de 150, queremos saber qué porcentaje de días vamos a tener al menos 3 trabajadores de baja.

Denotemos por \(N\) a la variable aleatoria que indica el número de trabajadores de baja en un día cualquiera, e identifiquemos el “éxito” por el hecho de “estar de baja.” Así, podemos asumir que la distribución de \(N\) es binomial, con tamaño 50 y probabilidad 0.03.

\[N \sim Bi(50,0.03).\]

En consecuencia, el valor esperado del número de trabajadores de baja cada día es \(E(N) = 50 \cdot 0.03=1.5\).

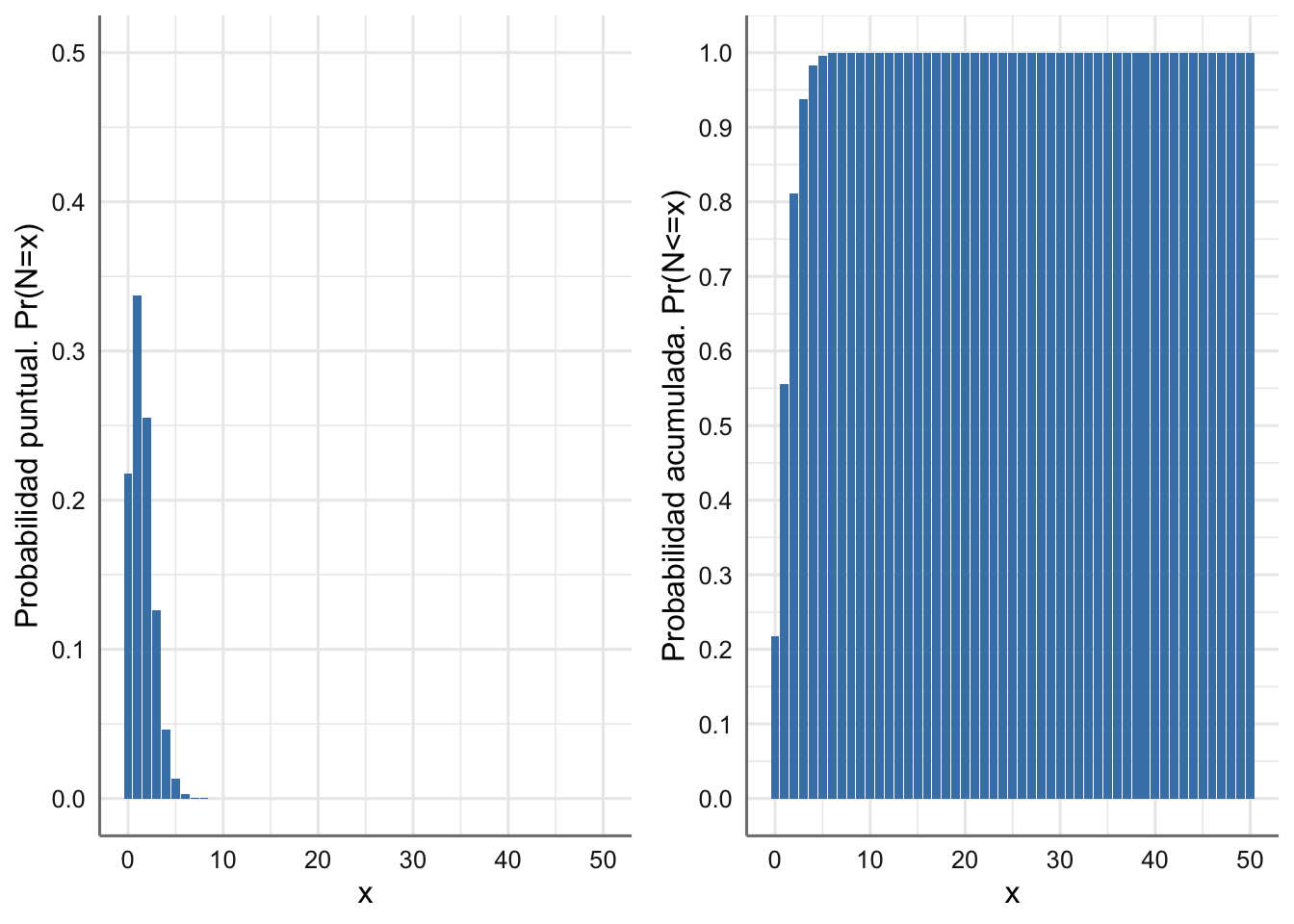

A continuación, en la Figura 1.1 representamos la fmp y la función de distribución asociadas.

# los valores posibles de la variable Bin(1000,0.03) son

xs <- 0:50

n=50

p=0.03

# Data frame

datos <- data.frame(xs = xs, probs = dbinom(xs, n,p),

probsacum = pbinom(xs, n,p))

# función de masa de probabilidad

g1 <- ggplot(datos, aes(x=xs, y=probs)) +

geom_bar(stat = "identity", fill = "steelblue") +

ylim(0,0.5) +

labs(x ="x", y = "Probabilidad puntual. Pr(N=x)")

# función de distribución

g2 <- ggplot(datos, aes(xs, probsacum)) +

geom_bar(stat = "identity", fill = "steelblue") +

scale_y_continuous(breaks = scales::breaks_extended(10)) +

labs(x ="x", y ="Probabilidad acumulada. Pr(N<=x)")

grid.arrange(g1, g2, nrow = 1)

Figura 1.1: Función de masa de probabilidad y Función de distribución para el número de trabajadores de baja un día cualquiera.

En la fmp (Figura 1.1-izquierda) podemos ver que en este caso la probabilidad se concentra en muy pocos valores, en concreto por debajo de 10, de modo que antes de llegar a \(x=10\) la probabilidad acumulada llega al valor 1, como se aprecia en la Figura 1.1-derecha.

La probabilidad que nos reclaman en el enunciado es \[Pr(N\geq 3)=1-Pr(N \leq 2),\] que calculamos y podemos aproximar por MC a partir, por ejemplo, de 1000 simulaciones.

nsim=1000

n=50

p=0.03

# valor real de la probabilidad

prob=1-pbinom(2,n,p)

cat("Pr(N>=3)=",round(prob,3))## Pr(N>=3)= 0.189

set.seed(1234)

# simulaciones

I.a=(rbinom(nsim,n,p)>=3)*1 # función indicatriz para la probabilidad requerida

prob=mean(I.a)

cat("AproxMC=",prob)## AproxMC= 0.193El error estimado de esta aproximación, que calculamos con la raíz cuadrada de (1.3) es

## Error.AproxMC= 0.012de donde podríamos calcular un intervalo de confianza para la aproximación MC de \(Pr(N \geq 3)\) al 95% utilizando la distribución (1.4) y la fórmula (1.5):

# límites del IC redondeados a 3 cifras decimales

ic.low=round(prob-qnorm(0.975)*error,3)

ic.up=round(prob+qnorm(0.975)*error,3)

cat("IC(95%)[AproxMC]=[",ic.low,",",ic.up,"]")## IC(95%)[AproxMC]=[ 0.169 , 0.217 ]Ejemplo 1.6 Una empresa de fabricación produce piezas, de las cuales el 97% están dentro de las especificaciones y el 3% son defectuosas (fuera de las especificaciones). Aparentemente no hay ningún patrón en la producción de piezas defectuosas. La cadena de producción empaqueta las piezas en cajas de 20 piezas cada una, y produce 1000 cajas al día. Al gerente de la empresa le gustaría estimar el número de cajas con al menos dos piezas defectuosas, de entre todas las que se producen al día durante un día cualquiera.

Si \(N\) es la variable aleatoria que recoge el número de piezas defectuosas en una caja, tenemos que:

\[N \sim Bi(20, 0.03)\]

La probabilidad de que una caja tenga al menos dos piezas defectuosas se calcula con \(p_N=Pr(N \geq 2)=1-Pr(N\leq 1)\).

n=20

p=0.03

prob=(1 - pbinom(1, n,p))

cat("Probabilidad de que una caja tenga al menos dos defectos=",prob)## Probabilidad de que una caja tenga al menos dos defectos= 0.119838Sin embargo, lo que nos piden es, de un total de 1000 cajas, cuál es el número esperado de cajas con al meos dos piezas defectuosas. Para ello, surge la variable \(D_N\) que representa el número de cajas, de un total de 1000, con al menos 2 piezas defectuosas, que es binomial de tamaño 1000 y probabilidad \(p_N\),

\[D_N \sim Bin(1000,p_N),\]

y lo que nos están pidiendo es \(E(D_N)=1000 p_N\).

Si simulamos con la distribución de \(N\) lo acontecido un día, esto es, con 1000 cajas o simulaciones, y contamos el número de cajas con 2 o más piezas defectuosas, obtenemos una aproximación a la cantidad que nos piden.

## [1] 99El problema es que no todos los días son iguales. De hecho si repites los siguientes cálculos varias veces, verás como el resultado varía. La aproximación Monte Carlo habría de considerar simulaciones de la variable \(D_n\) , esto es, nsim días, para con ellos poder sacar una conclusión “promedio” de lo que puede ocurrir un día cualquiera.

nsim=5000 # número de días simulados

n=1000

p=prob

# valor real del valor esperado

media=n*p

cat("E(D_N)=",round(media,3))## E(D_N)= 119.838## AproxMC= 119.7926

# Error MC

error=sqrt(sum((xi-m)^2)/(nsim^2))

# límites del IC redondeados a 3 cifras decimales

ic.low=round(m-qnorm(0.975)*error,3)

ic.up=round(m+qnorm(0.975)*error,3)

cat("IC(95%)[AproxMC]=[",ic.low,",",ic.up,"]")## IC(95%)[AproxMC]=[ 119.51 , 120.076 ]1.3.3 Geométrica

Imaginemos una situación experimental donde se repite un experimento hasta que sucede un “éxito.” En otras palabras, se piensa en \(\theta\) como la probabilidad de éxito para un solo ensayo, y realizamos sucesivamente los ensayos hasta que se produce un éxito. La variable aleatoria \(N\) se define entonces como el número de ensayos Bernouilli realizados hasta conseguir un éxito. Nótese que aunque la variable aleatoria geométrica es discreta, su rango es infinito, y su fmp viene dada por:

\[\begin{equation} Pr(N = x) = \theta (1-\theta)^{x} \text{ para } x = \text{1, 2,...} \tag{1.10} \end{equation}\]

con \(x\) el número de repeticiones hasta alcanzar un éxito, y \(\theta\) la probabilidad de éxito.

Definición 1.11 La variable aleatoria \(N\) cuya función de masa de probabilidad viene dada en (1.10) se denomina variable Geométrica de parámetro \(\theta\), y se denota por:

\[N \sim Ge(\theta)\]

con \(E(N) = \frac{1 - \theta}{\theta}\) y \(V(N) = \frac{1-\theta}{\theta^2}.\)Las funciones de R relacionadas con esta distribución se presentan a continuación, y tras ello un ejemplo de aplicación de la variable Geométrica.

- La función

dgeom(x, prob)nos permite evaluar la \(Pr(N=x)\) para una variable Geométrica con probabilidad de éxitoprob. -

pgeom(x, prob)calcula la función de distribución. -

rgeom(n, prob)permite generar \(n\) valores de una variable Geométrica con probabilidad de éxito \(prob\). Los resultados que proporciona son el número de repeticiones realizadas hasta alcanzar el primer éxito.

Ejemplo 1.7 Una vendedora de coches ha hecho un análisis estadístico de su historial de ventas anterior y ha determinado que cada día tiene un 10% de probabilidad de vender un coche de lujo. Tras un cuidadoso análisis posterior, también está claro que la venta de un coche de lujo en un día es independiente de la ventas realizadas cualquier otro día. El día de Año Nuevo (un día festivo en el que el concesionario estaba cerrado) la vendedora está intentando predecir cuándo venderá su primer coche de lujo del año.

Si consideramos \(N\) como la variable aleatoria que indica el día de la primera venta de coches de lujo (N = 1 implica que la venta se realizaría el día 2 de enero), entonces:

\[N \sim Ge(0.1)\]

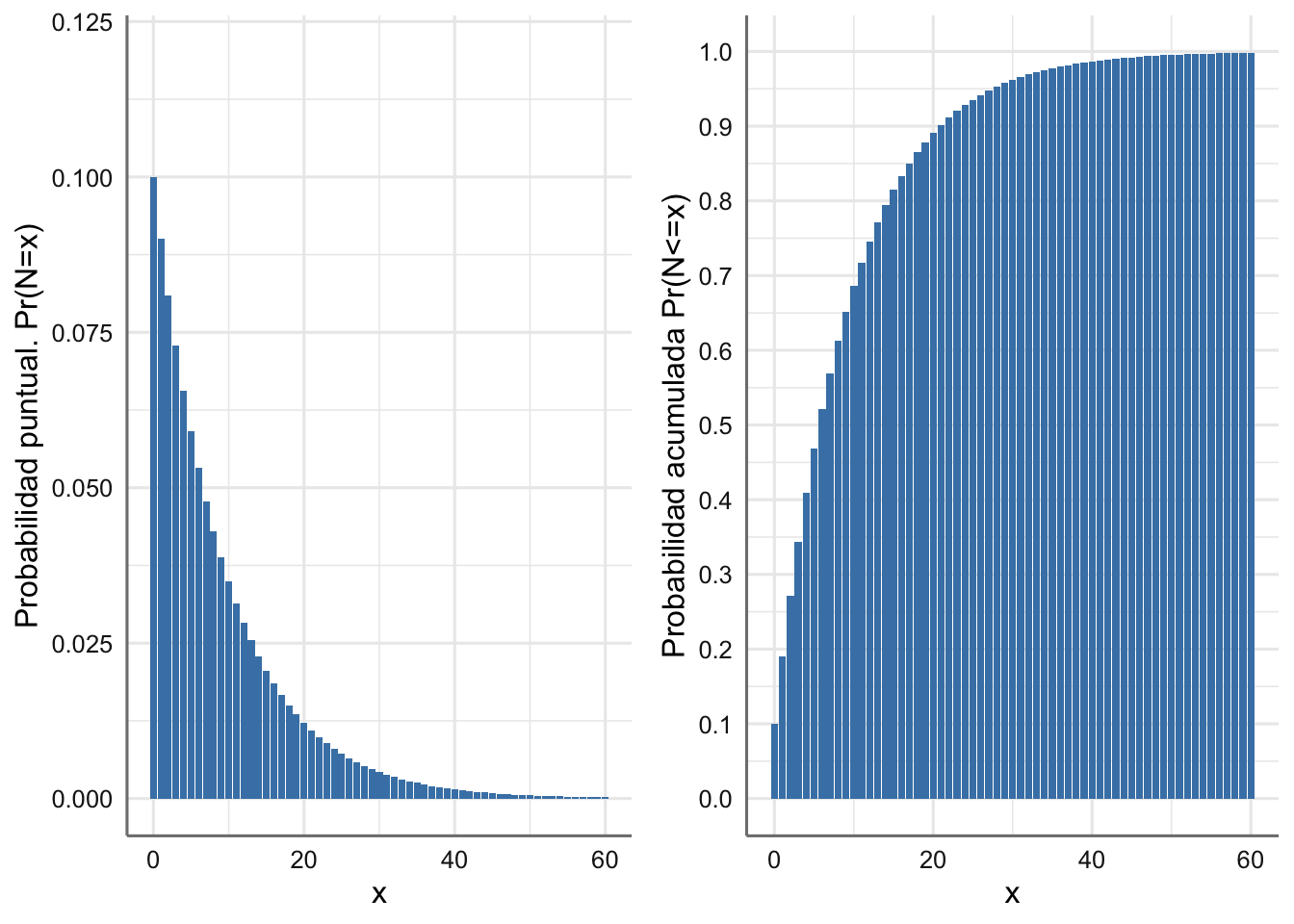

En este caso el valor esperado del número de días transcurridos hasta la venta del primer coche de lujo es \(E(N) = 0.9/0.1 = 9\) días, con una desviación típica de 9.5 días. Así pues, es posible que el día 10 de enero tenga su primera venta. En la Figura 1.2 se muestran la fmp y la función de distribución asociadas.

# Valores de N

xs <- seq(0, 60, 1)

# Data frame

datos <- data.frame(xs = xs, probs = dgeom(xs, 0.1),

probsacum = pgeom(xs, 0.1))

# función de masa de probabilidad

g1 <- ggplot(datos, aes(xs, probs)) +

geom_bar(stat = "identity", fill = "steelblue") +

ylim(0,0.12) +

labs(x ="x", y = "Probabilidad puntual. Pr(N=x)")

# función de distribución

g2 <- ggplot(datos, aes(xs, probsacum)) +

geom_bar(stat = "identity", fill = "steelblue") +

scale_y_continuous(breaks = scales::breaks_extended(10)) +

labs(x ="x", y = "Probabilidad acumulada Pr(N<=x)")

grid.arrange(g1, g2, nrow = 1)

Figura 1.2: Función de masa de probabilidad y Función de distribución para el día en que venderá el primer coche de lujo.

Hacemos a continuación un análisis de simulación para aproximar los datos teóricos dados en la definición 1.11. Simulamos 1000 valores de una \(Ge(0.1)\), con los que calculamos una aproximación al valor esperado de los días que deben transcurrir para vender un coche de lujo, y construimos un intervalo de confianza para la aproximación MC según (1.5).

# Parámetros de la simulación

set.seed(1970)

nsim <- 10000

prob <- 0.1

media<-(1-prob)/prob

cat("E(N)=",media)## E(N)= 9

# Valores simulados

datos <- rgeom(nsim, prob)

# Aproximación MC del valor esperado

m=round(mean(datos),0)

cat("AproxMC=",m)## AproxMC= 9

# Error MC

error=sqrt(sum((datos-m)^2)/(nsim^2))

# límites del IC redondeados a 3 cifras decimales

ic.low=round(m-qnorm(0.975)*error,3)

ic.up=round(m+qnorm(0.975)*error,3)

cat("IC(95%)[AproxMC]=[",ic.low,",",ic.up,"]")## IC(95%)[AproxMC]=[ 8.811 , 9.189 ]1.3.4 Poisson

La distribución de Poisson se emplea como un modelo para variables aleatorias de tipo discreto cuando se quieren obtener las probabilidades de ocurrencia de un evento que se distribuye al azar en el espacio o el tiempo. Algunos ejemplos de esta distribución se presentan a continuación.

En el estudio de cierto organismo acuático, se toman un gran número de muestras de un lago y se cuenta el número de dichos organismos que aparecen en cada muestra. Podríamos plantear como objetivo el conocer cuál es la probabilidad de encontrar dicho organismo en una próxima muestra si la media observada en el conjunto de muestras es de 2 organismos.

En un estudio sobre la efectividad de un insecticida sobre cierto tipo de insecto, se fumiga una gran región. Posteriormente se crea una cuadrícula sobre el terreno, se selecciona de forma aleatoria un conjunto de ellas, y se cuenta el número de insectos vivos dentro de cada una. Planteamos como objetivo conocer cuál es la probabilidad de que no encontremos ningún insecto vivo en una próxima cuadrícula si se sabe que la media de insectos vivos en las cuadrículas analizadas es de 0.5.

Un grupo de investigadores observó la ocurrencia de hemangioma capilar retiniano (RCH) en pacientes con la enfermedad de von Hippel-Lindau (VHL). RCH es un tumor vascular benigno de la retina. Usando una revisión retrospectiva de series de casos consecutivos, los investigadores encontraron que el número de medio de tumores RCH por ojo para pacientes con VHL era de 4. Están interesados en conocer cuál es la probabilidad de que se detecten más de cuatro tumores por ojo.

La variable aleatoria \(N\) se define entonces como el número de eventos que ocurren en un espacio o un tiempo determinados, y viene caracterizada por la denominada tasa de eventos o número medio de eventos que ocurren en el tiempo o espacio, y que se denota habitualmente por \(\lambda\). El rango de esta variable es infinito y su fmp viene dada por:

\[\begin{equation} Pr(N = x) = \frac{e^{-\lambda}\lambda^x}{x!} \text{ para } x = \text{1, 2,...} \tag{1.11} \end{equation}\]

con \(\lambda\) es la tasa y \(x\) es el número de eventos que han ocurrido.

Definición 1.12 La variable aleatoria \(X\) cuya función de masa de probabilidad viene dada en (1.11) se denomina variable poisson de parámetro \(\lambda > 0\), y se denota por:

\[N \sim Po(\lambda)\]

con \(E(N) = \lambda\) y \(V(N) = \lambda.\)A continuación vemos diferentes ejemplos de uso de la distribución de Poisson, tras presentar las funciones de R relacionadas.

- La función

dpois(x, lambda)nos permite evaluar la \(Pr(X=x)\) para una variable poisson de media \(\lambda\). -

ppois(x, lambda)calcula la función de distribución. -

rpois(n, lambda)permite generar \(n\) valores de una variable Poisson con media \(\lambda\). Los resultados que proporciona son el número de eventos que ocurren en el tiempo o espacio determinado.

Ejemplo 1.8 Una empresa de asesoramiento está realizando el análisis del funcionamiento de una panadería y ha estimado que el número medio de barras de pan que se venden en un periodo de media hora es de 12. La empresa está interesada en saber cuál es la capacidad de venta en cada franja de diez minutos (pues es prácticamente el tiempo de horneado), y también cuál es la probabilidad de que el número de barras que se venden en diez minutos sea exactamente de tres.

Como nuestro interés radica en un periodo de diez minutos y el número de intervalos de diez minutos en un periodo de 30 minutos es tres, tenemos que el número medio de barras puestas a la venta en ese periodo viene dado por:

\[\lambda = 12/3 = 4.\]

La variable aleatoria que reproduce el número de barras que se venden en una franja de cinco minutos es:

\[N \sim Po(4)\]

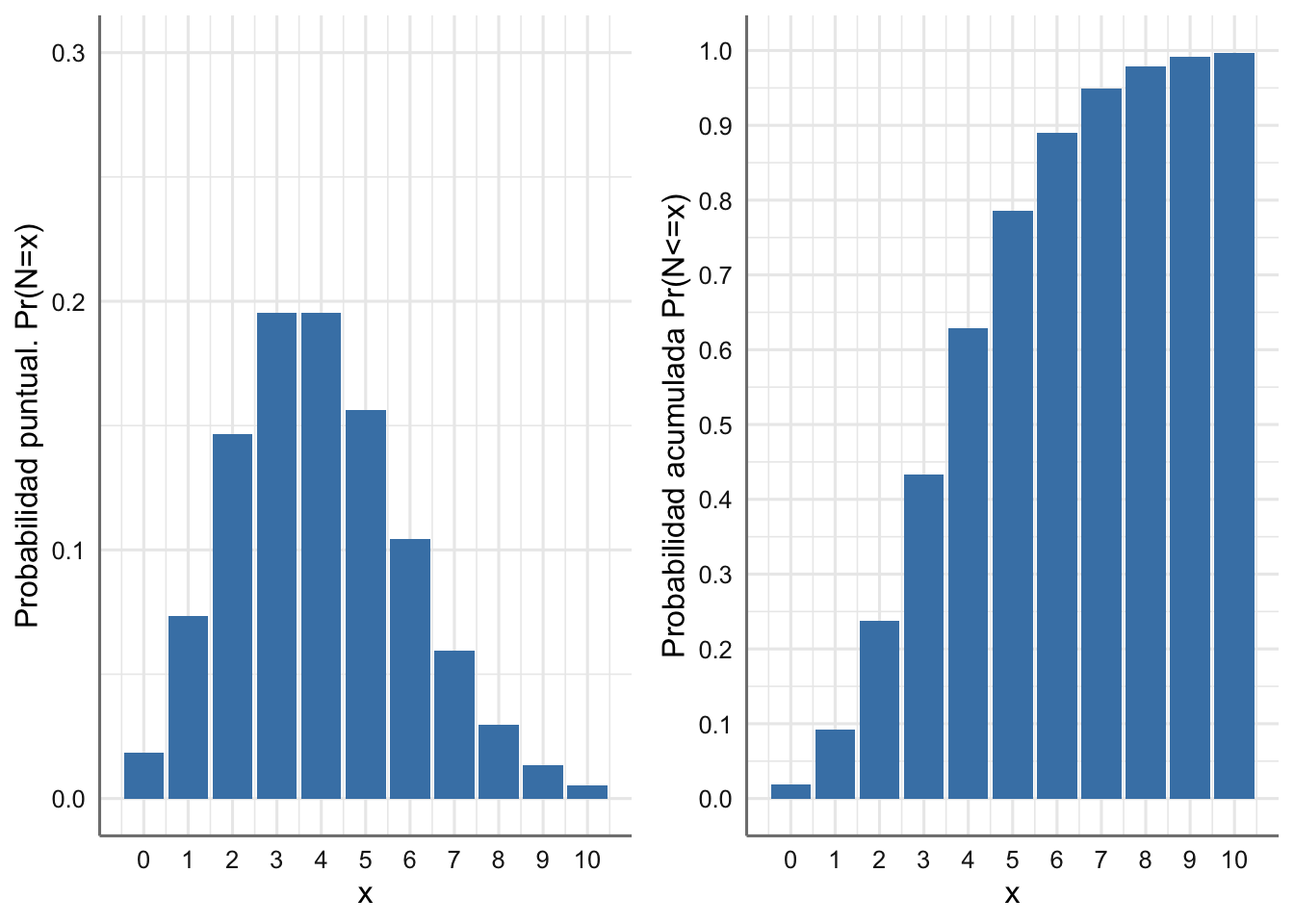

En este caso el valor esperado del número de barras que se venden es 4 y la desviación típica es igual a 2(\(=\sqrt{4}\)). En la Figura 1.3 se muestran la fmp y la función de distribución asociadas.

# Valores de N

lambda=4

xs <- seq(0, 10, 1)

# Data frame

datos <- data.frame(xs = xs, probs = dpois(xs, lambda),

probsacum = ppois(xs, lambda))

# función de masa de probabilidad

g1 <- ggplot(datos, aes(xs, probs)) +

geom_bar(stat = "identity", fill = "steelblue") +

scale_x_continuous(breaks = 0:10, labels = 0:10) +

ylim(0,0.3) +

labs(x ="x", y = "Probabilidad puntual. Pr(N=x)")

# función de distribución

g2 <- ggplot(datos, aes(xs, probsacum)) +

geom_bar(stat = "identity", fill = "steelblue") +

scale_x_continuous(breaks = 0:10, labels = 0:10) +

scale_y_continuous(breaks = scales::breaks_extended(10)) +

labs(x ="x", y = "Probabilidad acumulada Pr(N<=x)")

grid.arrange(g1, g2, nrow = 1)

Figura 1.3: Función de masa de probabilidad y Función de distribución para el número de barras de pan que se venden cada cinco minutos.

Podemos reconoder en la Figura 1.3-izquierda los valores más probables con las barras más altas (3 y 4). De hecho, en la Figura 1.3-derecha, la probabilidad de que a lo sumo se vendan menos de 5 barras es algo superior a 0.6.

Para calcular la probabilidad pretendida, esto es, \(Pr(N=3)\) utilizamos la función fmp correspondiente en R y la aproximamos por MC con 1000 simulaciones, dando también una banda de confianza.

lambda=4

# Probabilidad buscada P(N=3) para la poisson con media 2

media=dpois(3,lambda)

cat("Pr(N=4)=",round(media,3))## Pr(N=4)= 0.195

nsim <- 10000

# Simulamos de la poisson y evaluamos la función indicatriz para la prob de interés

set.seed(1970)

I.a <- (rpois(nsim, lambda)==3)*1

# Realizamos la aproximación MC

m=mean(I.a)

cat("AproxMC=",m)## AproxMC= 0.1934

# Error MC

error=sqrt(sum((I.a-m)^2)/(nsim^2))

# límites del IC redondeados a 3 cifras decimales

ic.low=round(m-qnorm(0.975)*error,3)

ic.up=round(m+qnorm(0.975)*error,3)

cat("IC(95%)[AproxMC]=[",ic.low,",",ic.up,"]")## IC(95%)[AproxMC]=[ 0.186 , 0.201 ]Si la aproximación la hacemos con 10 veces más simulaciones, el intervalo de estimación resultará más preciso:

lambda=4

# Probabilidad buscada P(N=3) para la poisson con media 2

media=dpois(3,lambda)

cat("Pr(N=4)=",round(media,3))## Pr(N=4)= 0.195

nsim <- 10000*10

# Simulamos de la poisson y evaluamos la función indicatriz para la prob de interés

set.seed(1970)

I.a <- (rpois(nsim, lambda)==3)*1

# Realizamos la aproximación MC

m=mean(I.a)

cat("AproxMC=",m)## AproxMC= 0.19375

# Error MC

error=sqrt(sum((I.a-m)^2)/(nsim^2))

# límites del IC redondeados a 3 cifras decimales

ic.low=round(m-qnorm(0.975)*error,3)

ic.up=round(m+qnorm(0.975)*error,3)

cat("IC(95%)[AproxMC]=[",ic.low,",",ic.up,"]")## IC(95%)[AproxMC]=[ 0.191 , 0.196 ]Ejemplo 1.9 Una empresa de fabricación de galletas de chocolate está analizando la calidad en su empresa para responder del mejor modo posible a sus clientes. Para ello ha fijado que con probabilidad 0.8 las galletas deben contener al menos tres trozos de chocolate para satisfacer las exigencias de los clientes. Se trata pues de fijar el valor medio de trozos de chocolate que debe ir suministrando en la cadena de producción para cumplir con el nivel de exigencia establecido.

Si \(N\) es la variable aleatoria que indica el número de trozos de chocolate en una galleta, tenemos que:

\[N \sim Po(\lambda)\]

donde en este caso el valor de \(\lambda\) es desconocido y representa el número medio de trozos de chocolate en cada galleta. Planteamos un estudio de simulación para aproximar dicho valor.

Algoritmo para aproximar el valor de \(\lambda\).

- Considerar una secuencia de valores de \(\lambda_i\), \(i=1,...,K\)

- Obtener una muestra de tamaño \(nsim\) para cada distribución \(Po(\lambda_i)\), \(M_i=\{x_{i_1},\ldots,x_{i_{nsim}}\}\).

- Con cada muestra \(M_i\) aproximar la probabilidad de que el número de trozos sea mayor o igual a 3, \(p_i\approx Pr(N_{\lambda_i}\geq3)\).

- Obtener el valor mínimo de \(\lambda\), de entre \(\{\lambda_1,\ldots,\lambda_K\}\) que verifica \(p_i \geq 0.8\).

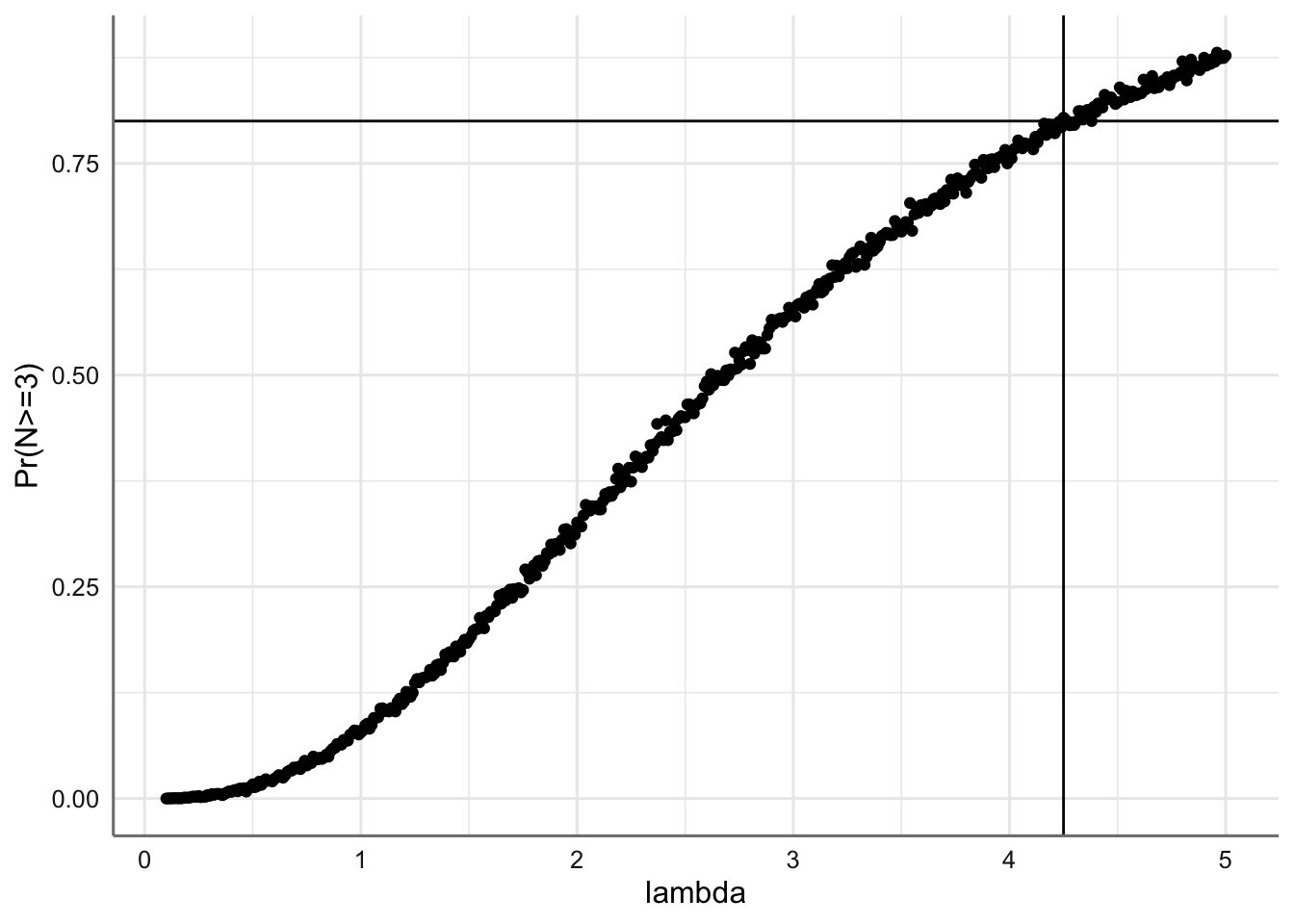

En la Figura 1.4 se muestra el proceso de simulación realizado a continuación y el resultado obtenido para el valor de \(\lambda\) para cumplir los requisitos de la empresa.

# Paso 1

set.seed(1970)

nsim <- 5000

lams <- seq(0.1, 5, 0.01) # valores de lambda

nlams <- length(lams) # número de lambdas para evaluar

prob <- c() # vector de probabilidades

# Pasos 2 y 3

for(i in 1:nlams){

datos <- rpois(nsim, lams[i])

prob[i] <- mean(datos >= 3)

}

# Paso 4. Resultado del problema

lambda=lams[min(which(prob >= 0.8))];lambda## [1] 4.25

# Pintamos los resultados de la simulación realizada

dat=data.frame(lams=lams,prob=prob)

ggplot(dat,aes(x=lams,y=prob))+

geom_point()+

geom_hline(yintercept=0.8)+

geom_vline(xintercept=lambda)+

labs(x="lambda",y="Pr(N>=3)")

Figura 1.4: Probabilidad estimada de conseguir al menos 3 trozos de chocolate en cada galleta, en función de lambda.

Así pues, el número medio de trozos de chocolate que ha de suministrarse a cada galleta ha de ser al menos de 4.25.

1.4 Distribuciones continuas

En este punto estudiamos las principales variables de tipo continuo. La especificación de estas variables se hace a partir de la función de densidad.

1.4.1 Uniforme

La distribución uniforme es la distribución de probabilidad continua más sencilla y se refiere a eventos infinitos que tienen la misma probabilidad de ocurrir en una intervalo dado. Si \(a\) y \(b\) son dos números reales con \(a < b\) entonces la función de distribución asociada a la probabilidad acumulada a la izquierda de cualquier valor \(x \in [a, b]\) viene dada por:

\[\begin{equation} F(x) = \begin{cases} 0 & \text{ si } x < a \\ \frac{x-a}{b-a} & \text{ si } a \leq x \leq b\\ 1 & \text{ si } a \leq x \leq b. \end{cases} \tag{1.12} \end{equation}\]

Definición 1.13 Una variable aleatoria \(X\) tiene una distribución uniforme en el intervalo \([a, b]\), con $a,b R,

\[X \sim U(a,b)\]

si su función de densidad viene dada por la expresión

\[\begin{equation} f(x) = \begin{cases} \frac{1}{b-a} & \text{ si } a \leq x \leq b\\ 0 & \text{ en otro caso } \end{cases} \tag{1.13} \end{equation}\]

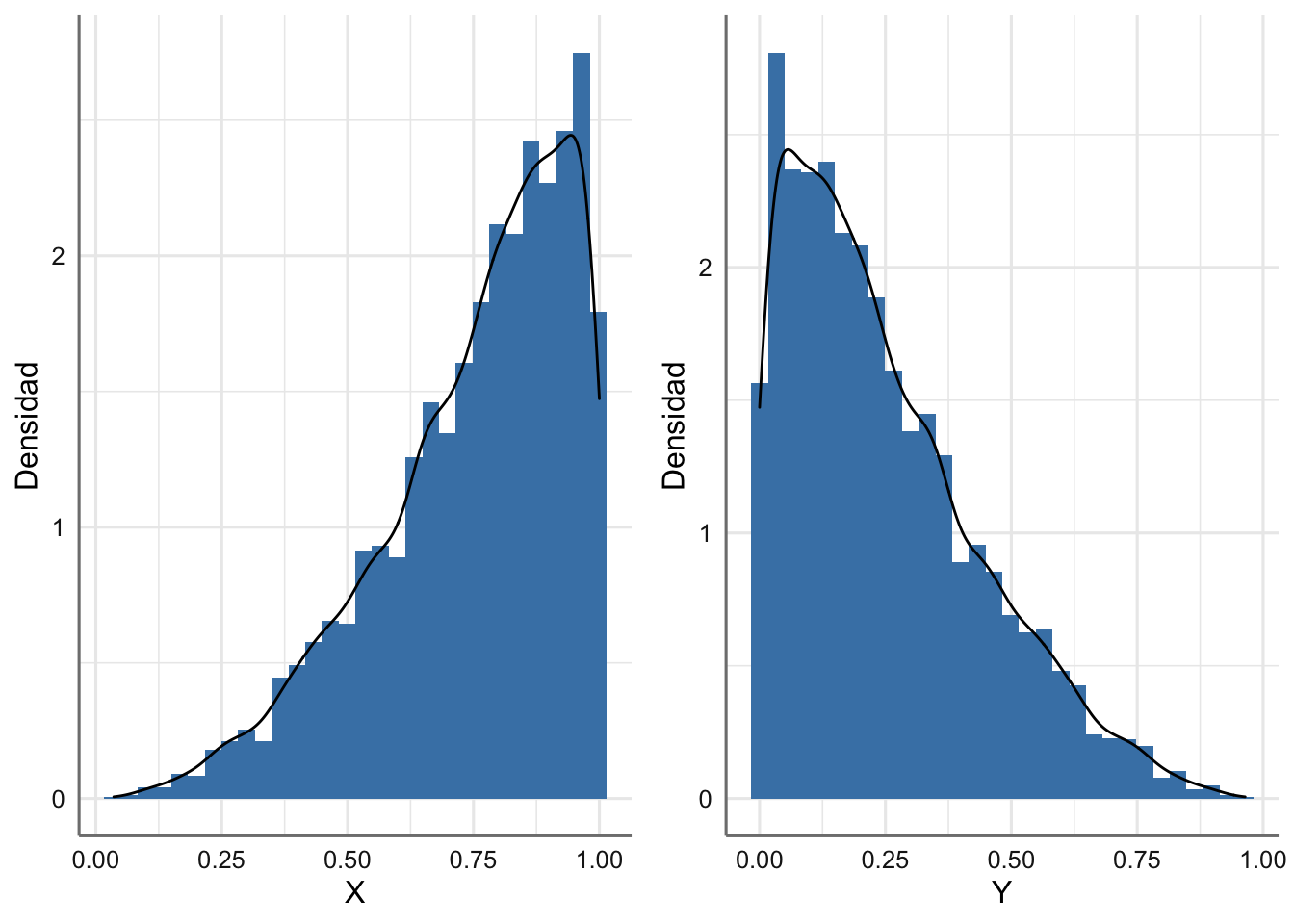

de forma que \(E(X) = (a+b)/2\) y \(V(X) = (b-a)^2/12.\)La variable uniforme más famosa es la \(U(0,1)\) ya que se utiliza habitualmente para modelizar la incertidumbre sobre una probabilidad desconocida, y es la base para muchos de los algoritmos de simulación de variables y procesos que estudiaremos en el futuro.

- La función

runif(n, a, b)permite generar \(n\) valores de una variable uniforme en el intervalo \([a, b]\);runif(n)da una muestra para una distribución uniforme en [0, 1]. -

dunif(x,a,b)da la fdp en \(x\). -

punif(x,a,b)da la probabilidad acumulada para cualquier punto \(x \in [a,b]\).

1.4.2 Exponencial

La distribución exponencial es una distribución muy común en la modelización probabilística. Esta distribución describe procesos que describen el tiempo entre sucesos consecutivos, con la peculiaridad de que sus probabilidades no dependen del instante en que se produzcan los eventos. Es decir:

\[Pr(X > t+s | X > t) = Pr(X > s).\]

Esta propiedad es característica de la distribución exponencial y se denomina “propiedad de la pérdida de memoria.”

Ejemplos de este tipo de distribución son:

El tiempo que tarda una partícula radiactiva en desintegrarse. El conocimiento de la ley que sigue este evento se utiliza en ciencias para, por ejemplo, la datación de fósiles o cualquier materia orgánica mediante la técnica del carbono 14.

El tiempo que puede transcurrir en un servicio de urgencias, entre llegadas de pacientes, o en una fábrica entre roturas de una máquina.

Esta distribución está muy relacionada con unos procesos que estudiaremos más adelante, denominados Procesos de Poisson.

La distribución exponencial viene completamente especificada, a través del parámetro \(\lambda >0\) que mide el número esperado de veces que ocurre el evento de interés por cada unidad de tiempo, y cuya función de distribución viene dada por:

\[\begin{equation} F(x) = \begin{cases} 0 & \text{ si } x < 0 \\ 1 - e^{\lambda x} & \text{ si } x \geq 0. \end{cases} \tag{1.14} \end{equation}\]

Definición 1.14 Una variable aleatoria \(X\) tiene una distribución exponencial de parámetro \(\lambda\), que se denota por

\[X \sim Exp(\lambda)\]

si su función de densidad viene dada por

\[\begin{equation} f(x)=\lambda e^{-\lambda x}, \quad x \geq 0, \end{equation}\]

de forma que \(E(X) = 1/\lambda\) y \(V(X) = 1/\lambda^2.\)

Las funciones relacionadas con la distribución exponencial en R son:

- La función

dexp(x, lambda)nos permite evaluar la función de densidad para una variable poisson de parámetro \(\lambda\). -

pexp(x, lambda)nos permite evaluar la función de distribución. -

rexp(n, lambda)permite generar \(n\) valores de una variable Exponencial de parámetro \(\lambda\).

A continuación estudiamos dos ejemplos de uso de la distribución exponencial. Como siempre presentamos los resultados téoricos y procedemos mediante simulación para ver la aproximación conseguida.

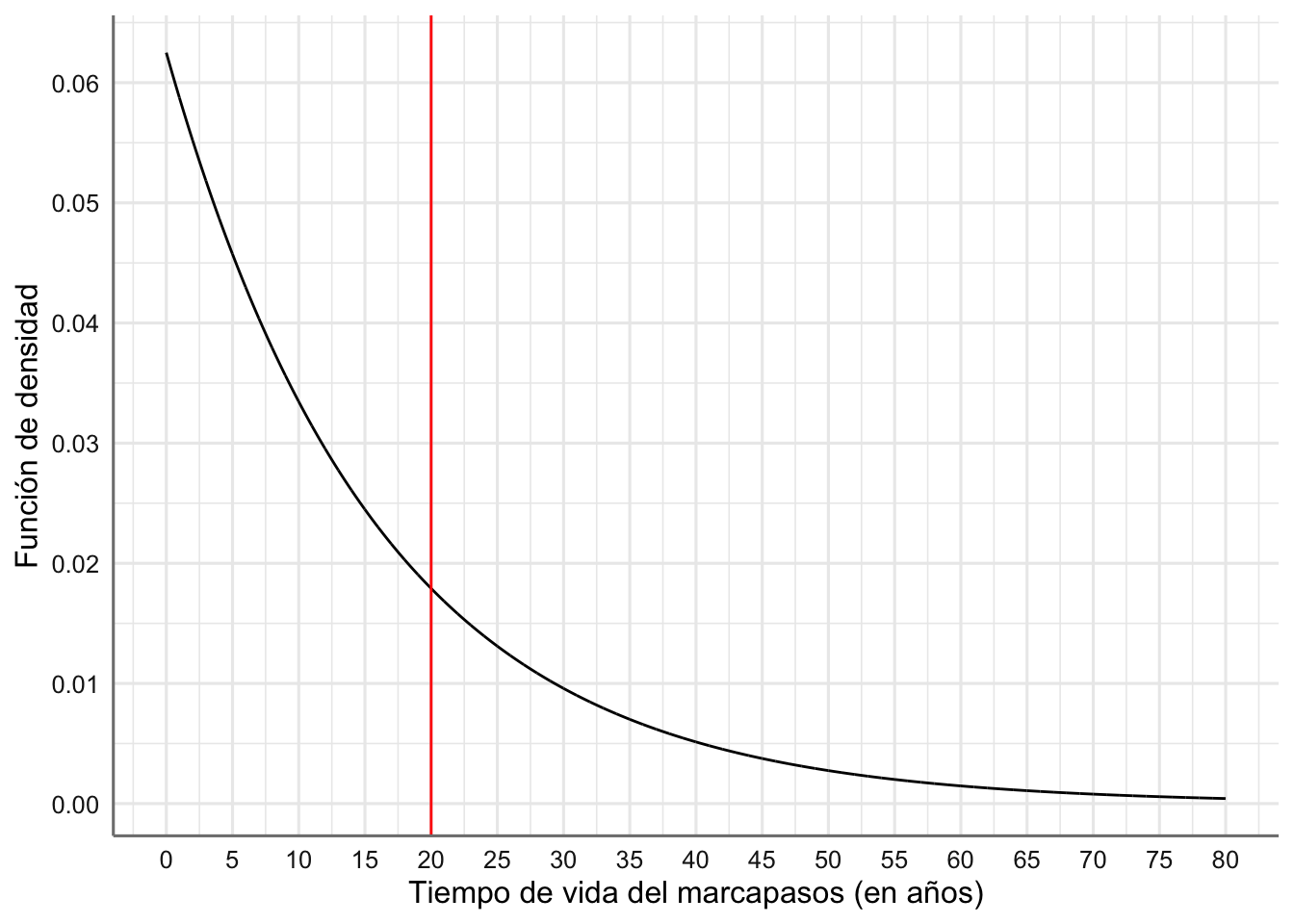

Ejemplo 1.10 Se ha comprobado que el tiempo de vida de cierto tipo de marcapasos sigue una distribución exponencial con media 16 años. (1) ¿Cuál es la probabilidad de que a una persona a la que se le ha implantado este marcapasos se le deba reimplantar otro antes de 20 años? (2) Si el marcapasos lleva funcionando correctamente 5 años en un paciente, ¿cuál es la probabilidad de que haya que cambiarlo antes de 25 años desde que se implantó?

Si \(T\) es la variable aleatoria que indica el tiempo de vida del marcapasos tenemos que:

\[T \sim Exp(\lambda = 1/16)\]

Se puede reponder fácilmente a las preguntas planteadas sin más que hacer uso de la función pexp(). Sin embargo, también simularemos para aproximarlas. Hemos de calcular

(1). Si es preciso implantar antes de 20 años, es porque el tiempo de vida no va a ser superior a 20. Hemos de calcular pues, \(Pr(T \leq 20)\). (2). Nos piden \(Pr(T \leq 25|T>5)=Pr(T\leq 20)\), por la propiedad de la pérdida de memoria. Es decir, respondiendo a (1) tendremos respondidas las dos preguntas formuladas.

lambda <- 1/16

# Data frame para la representación gráfica

sec <- seq(0, 80, by = 0.01)

datos<- data.frame(sec = sec, densidad = dexp(sec,lambda))

# Gráfico función de densidad

ggplot(datos, aes(sec, densidad)) +

geom_line() +

scale_x_continuous(breaks = seq(0,80,5), labels = seq(0,80,5)) +

scale_y_continuous(breaks = scales::breaks_extended(10)) +

geom_vline(xintercept = 20, col = "red") +

labs(x ="Tiempo de vida del marcapasos (en años)",

y = "Función de densidad")

Figura 1.5: Función de densidad del tiempo de vida del marcapasos (en años)

Obtenemos la probabilidad deseada:

## Pr(T<=20)= 0.713

# Parámetros de la simulación

set.seed(123)

nsim <- 5000

# Simulaciones

datos <- rexp(nsim, lambda)

# Probabilidad de interés

pMC=mean(datos <= 20)

cat("Aprox.MC[Pr(T<=20)]=",round(pMC,3))## Aprox.MC[Pr(T<=20)]= 0.711La probabilidad de que el marcapasos dure más de 20 años y haya que reemplazarlo es de 0.289, por lo que efectivamente, es muy recomendable reemplazarlo antes. Sin embargo, al paciente en la pregunta (2) se le daría la misma recomendación, cuando la probabilidad de que el marcapasos dure más de 25 años desde su implante, que sería el tiempo que lo llevaría, es considerablemente inferior, 0.21. No es pues recomendable, utilizar esta distribución para modelizar el tiempo de vida de un implante.

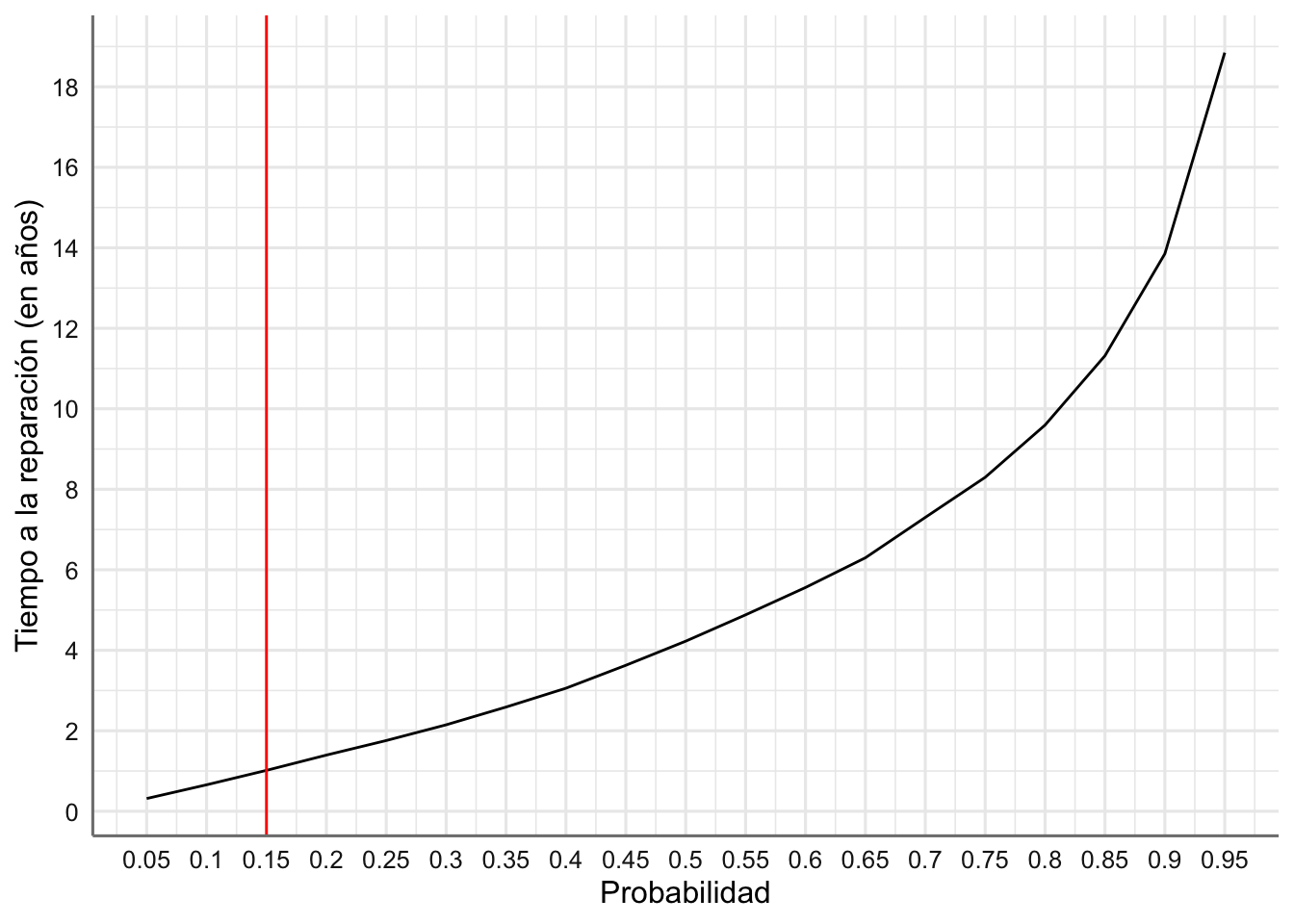

Ejemplo 1.11 Un motor eléctrico tiene una vida media de 6 años y se modeliza con una distribución exponencial. ¿Cuál debe ser el tiempo de garantía que debe tener el motor si se desea que a lo sumo el 15 % de los motores fallen antes de que expire su garantía?

Si \(T\) es la variable aleatoria que indica el tiempo de vida del producto tenemos que: \[T \sim Exp(\lambda = 1/6).\]

En este caso estamos interesados en encontrar el tiempo para que podamos garantizar que el 85% de los motores siguen funcionando, es decir, buscamos el cuantil 0.15 de la distribución de \(T\). Planteamos un análisis de simulación para estimar dicho valor.

# Calculamos el valor real para el periodo de garantía

lambda <- 1/6

q=qexp(0.15,lambda)

cat("Periodo de garantía recomendado=",round(q,2))## Periodo de garantía recomendado= 0.98

# Parámetros de la simulación

set.seed(123)

nsim <- 5000

# simulaciones

datos <- rexp(nsim, lambda)

# cuantil de interés

qMC=quantile(datos, 0.15)

cat("Periodo de garantía aproximado=",round(qMC,2))## Periodo de garantía aproximado= 1.02Para que tan sólo el 15% de los motores necesiten reparación durante el periodo de garantía, debemos establecer una garantía de aproximadamente 1 año.

En la Figura 1.6 se representan, para los datos simulados, los cuantiles aproximados versus su probabilidad asociada. Con el gráfico se puede atisbar también el periodo de garantía recomendado.

# cuantil de interés

probs <- seq(0.05, 0.95, by = 0.05)

cuantiles <- quantile(datos, probs)

datoscuan <- data.frame(probs, cuantiles)

# Gráfico

ggplot(datoscuan, aes(probs,cuantiles)) +

geom_line() +

scale_x_continuous(breaks = probs, labels = probs) +

scale_y_continuous(breaks = scales::breaks_extended(10)) +

geom_vline(xintercept = 0.15, col = "red") +

labs(x ="Probabilidad", y = "Tiempo a la reparación (en años)")

Figura 1.6: Tiempo de garantía recomendado en función de la probabilidad de que los motores necesiten reparación.

Con esta gráfica podemos establecer el tiempo de garantía en función de las especificaciones de la empresa, es decir, fijando el porcentaje de motores que necesitarán reparación.

1.4.3 Gamma

La distribución Gamma, al igual que ocurre con la exponencial, se utiliza habitualmente para modelizar variables aleatorias positivas y asimétricas, y sobre todo para describir procesos de eventos que ocurren en el tiempo. La función de densidad de una variable aleatoria Gamma se caracteriza por dos parámetros: \(\alpha\) o parámetro de forma, y \(\beta\) o parámetro de escala. El parámetro de forma se denomina así porque al variar su valor se obtienen diferentes formas para la fdp. La variación del parámetro de escala no cambia la forma de la distribución, pero tiende a “estirar” o “comprimir” el rango de valores sobre el que se define la probabilidad.

Definición 1.15 Una variable aleatoria \(X\), con \(x \geq 0\), tiene una distribución Gamma de parámetros \(\alpha > 0\) y \(\beta > 0\), denotada por

\[X \sim Ga(\alpha, \beta)\]

si su función de densidad viene dada por la expresión

\[\begin{equation} f(x) = \frac{x^{\alpha -1} e^{-x/\beta}}{\beta^{\alpha} \Gamma(\alpha)}; \quad \text{ para } x \geq 0, \tag{1.15} \end{equation}\]

con \(\Gamma()\) la función gamma, de forma que \(E(X) = \alpha\beta\) y \(V(X) = \alpha\beta^2.\)

Un caso especial de la distribución Gamma es la distribución Erlang, que se denota por \(X \sim Erlang(k, \beta)\), y que se utiliza habitualmente en la modelización de sistemas de colas de espera. Su función de densidad viene dada por :

\[\begin{equation} f(x) = \frac{k(kx)^{\alpha -1} e^{-xk/\beta}}{\beta^{k} (k-1)!}; \quad \text{ para } x \geq 0, \tag{1.16} \end{equation}\]

con \(E(x) = \beta\) y \(V(X) = \beta^2/k\). La utilidad de una variable aleatoria Erlang con parámetros \(k\) y \(\beta\) es que es el resultado de sumar \(k\) variables aleatorias exponenciales (independientes) cada una con media \(\beta/k\). En la modelización de los tiempos relacionados con un proceso industrial, la distribución exponencial suele ser inadecuada porque la desviación estándar no es tan grande como la media. Los ingenieros suelen tratar de diseñar sistemas que produzcan una desviación estándar de los tiempos del proceso que resulte significativamente menor que su media. La distribución Erlang tiene esta propiedad: su desviación estándar disminuye a medida que aumenta \(k\), de modo que los tiempos de proceso con una desviación estándar pequeña a menudo suelen ser aproximados por una variable aleatoria Erlang.

- La función

dgamma(x, shape, scale)nos permite evaluar la función de densidad para una variable Gamma. -

pgamma(x, shape, scale)calcula la función de distribución. -

rgamma(n, shape, scale)permite generar \(n\) valores de una variable Gamma.

Para simular un dato de una distribución \(y \sim (Erlang(k, \beta)\)) generamos \(k\) datos exponenciales de \(x_i \sim Exp(\beta/k), i=1,\ldots,k,\) y calculamos la suma de todos esos valores,\(y=\sum_i x_i\). Repetir este proceso tantas veces como indique el tamaño de la muestra simulada que deseamos para la distribución Erlang.

Si disponemos de la media y varianza de los datos resulta muy fácil ajustar los parámetros de la distribución Gamma o Erlang sin más que resolver las ecuaciones que nos dan el valor esperado y la varianza. Si \(\bar{x}\) y \(s^2\) son respectivamente la media y varianza, podemos ajustar los parámetros de la Gamma con:

\[ \beta = s^2/\bar{x}; \quad \alpha = \bar{x}/\beta\]

mientras que para la Erlang tenemos:

\[ \beta = \bar{x}; \quad k = \bar{x}^2/s^2.\]

A continuación se presenta la función para generar datos Erlang a patir de datos exponenciales:

# Función para generar "nsim" simulaciones de una Erlang

# con parámetros k (entero) y beta>0

rerlang <- function(nsim, k, beta)

{

# verificamos que k es entero

if(k%%1 == 0)

{

# parámetro de la exponencial

lambda <- beta/k

# Generamos y almacenamos datos exponenciales

datosexp <- matrix(rexp(nsim*k, lambda), nrow = nsim)

# Obtenemos la muestra de la Erlang

datoserl <- apply(datosexp, 1, sum)

return(datoserl)

}

else{

cat("k debe ser entero")

}

}1.4.4 Weibull

La distribución Weibull se utiliza para describir la resistencia a la rotura de diversos materiales o para describir los tiempos de fallo de muchos tipos de sistemas diferentes. La distribución Weibull tiene dos parámetros: un parámetro de escala, \(\beta\) , y un parámetro de forma \(\alpha\), ambos positivos. La funcion de distribución asociada viene dada por:

\[\begin{equation} F(x) = \begin{cases} 0 & \text{ si } x < 0 \\ 1 - e^{-(x/\beta)^{\alpha}} & \text{ si } x \geq 0 \end{cases} \tag{1.17} \end{equation}\]

Como en el caso de la distribución Gamma el parámetro de forma determina la forma general de la fdp y el parámetro de escala expande o contrae la fdp.

Definición 1.16 Una variable aleatoria \(X\) tiene una distribución Weibull de parámetros \(\alpha>0\) y \(\beta>0\), que se denota por

\[X \sim Weib(\alpha, \beta)\]

si su función de densidad viene dada por la expresión

\[\begin{equation} f(x)=\frac{\alpha}{\beta}\frac{x}{\beta}^{\alpha-1}e^{-(x/\beta)^{\alpha}}, \quad x \geq 0. \tag{1.18} \end{equation}\]

El valor esperado y la varianza vienen dados por:

\[E(X) = \beta \Gamma(1 + 1/\alpha); \quad V(X) = \beta^2 (\Gamma(1 + 2/\alpha) - (\Gamma(1 + 1/\alpha))^2).\]

En R tenemos las siguientes funciones relacionadas con la distribución Weibull.

- La función

dweibull(x, shape, scale)nos permite evaluar la función de densidad para una variable Weibull -

pweibull(x, shape, scale)calcula la función de distribución. -

rweibull(n, shape, scale)permite generar \(n\) valores de una variable Weibull.

A partir de la media (\(\bar{x}\)) y varianza (\(S^2\)) de un conjunto de datos, es posible obtener los parámetros de la distribución Weibull sin más que resolver las ecuaciones:

\[\begin{eqnarray} \beta &=& \frac{\bar{x}}{\Gamma(1 + 1/ \alpha)} \\ \frac{s^2}{\bar{x}^2} - \frac{\Gamma(1+ 2/\alpha)}{(\Gamma(1 + 1/ \alpha))^2} + 1 &=& 0. \tag{1.19} \end{eqnarray}\]

A continuación se propone una función que permite obtener los parámetros a partir de la media y varianza de los datos, junto con un pequeño ejemplo para verificar su funcionalidad.

estima.weibull <- function(m, s)

{

#m=media, s=desviación típica

library(rootSolve)

# Función para optimizar alpha

fun.alpha <- function(a, m, s)

{

res<- 1 + (s/m)^2 - gamma(1+2/a)/(gamma(1+1/a))^2

return(res)

}

# Obtención de alpha

alpha <- round(uniroot(fun.alpha, c(0.1, 10000),m=m,s=s)$root,2)

# Obtención de beta

beta <- round(m/gamma(1+1/alpha), 2)

# Devolvemos alpha y beta

return(c(alpha, beta))

}

# Datos de ejemplo

m <- 80 # media

s <- sqrt(50) # desviación típica

# Estimación

res=estima.weibull(m,s)

cat("Weibull alpha=",res[1],", Weibull beta=",res[2])## Weibull alpha= 13.83 , Weibull beta= 83.061.4.5 Normal

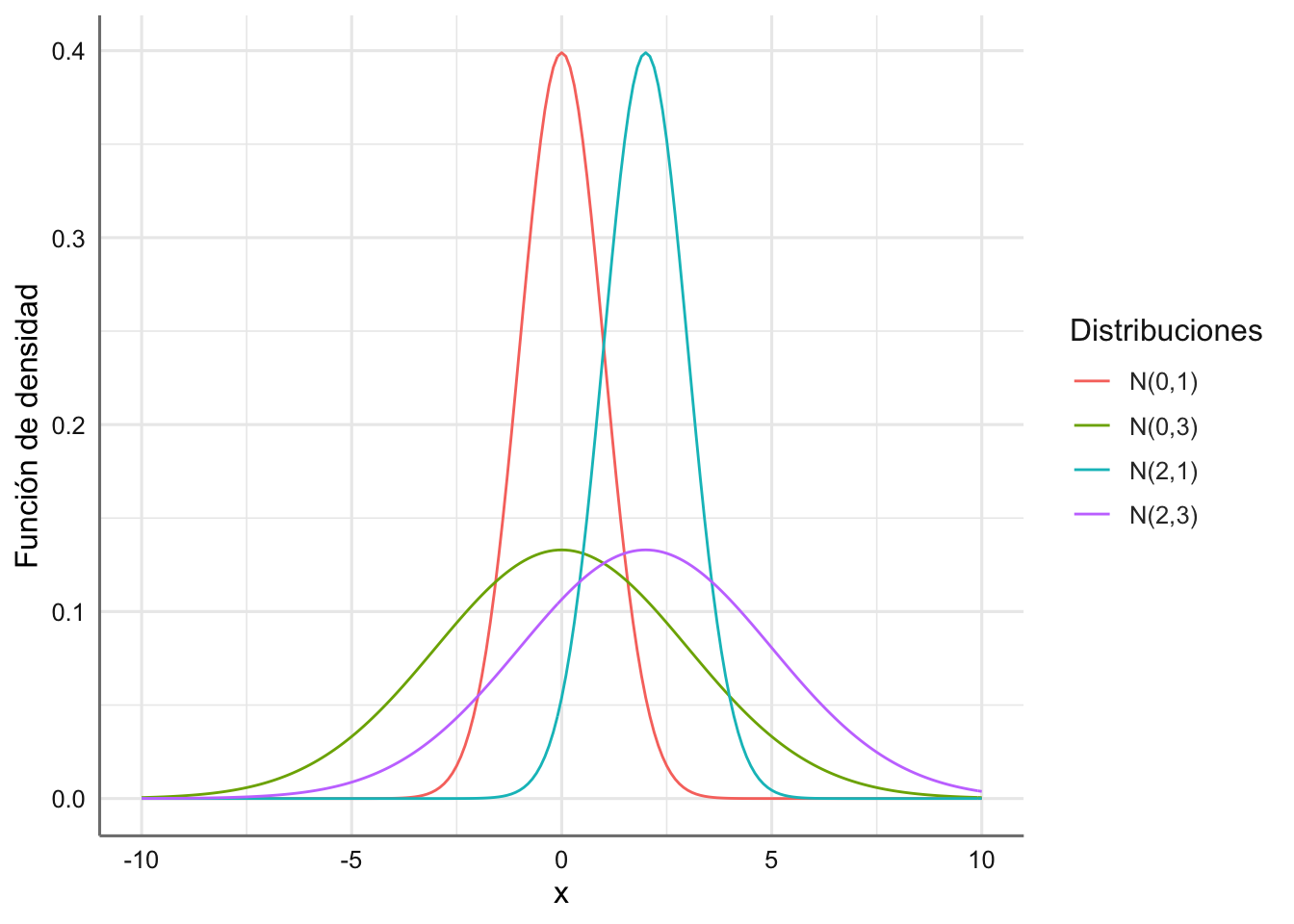

La distribución normal es la distribución más común, reconocida por la mayoría de personas por su curva en forma de “campana,” y también llamada “campana de Gauss.” Aunque la distribución normal no se utiliza mucho en la modelización de procesos y sitemas, es sin duda, la más relevante de las distribuciones aleatorias, ya que representa el supuesto básico distribucional para resolver muchos de los problemas de inferencia estadística habituales, como veremos en la sección final de esta unidad.

Definición 1.17 Una variable aleatoria \(X\) tiene una distribución Normal de parámetros \(\mu\) y \(\sigma\) con \(\sigma >0\), denotada por

\[ X \sim N(\mu, \sigma^2),\]

si su función de densidad viene dada por

\[\begin{equation} f(x) = \frac{1}{\sigma\sqrt{2\pi}} exp\left(\frac{-(x-\mu)^2}{2\sigma^2}\right), \quad x \in R \end{equation}\]

con \(E(X) = \mu\) y \(V(X) = \sigma^2\), y que se denota:

El parámetro \(\mu\) identifica la media, y por lo tanto el centro de la distribución al ser simétrica, y el parámetro \(\sigma\) la desviación típica.

El caso más destacado es la denominada distribución Normal estándar, para la que \(\mu = 0\) y \(\sigma = 1\), por su utilización en problemas inferenciales sencillos donde la variabilidad es conocida.

A partir de cualquier distribución Normal podemos transformar a una distribución Normal estándar. Si \(X \sim N(\mu, \sigma^2)\) entonces la variable aleatoria \(Z\) definida como

\[Z = \frac{X - \mu}{\sigma} \sim N(0,1).\]

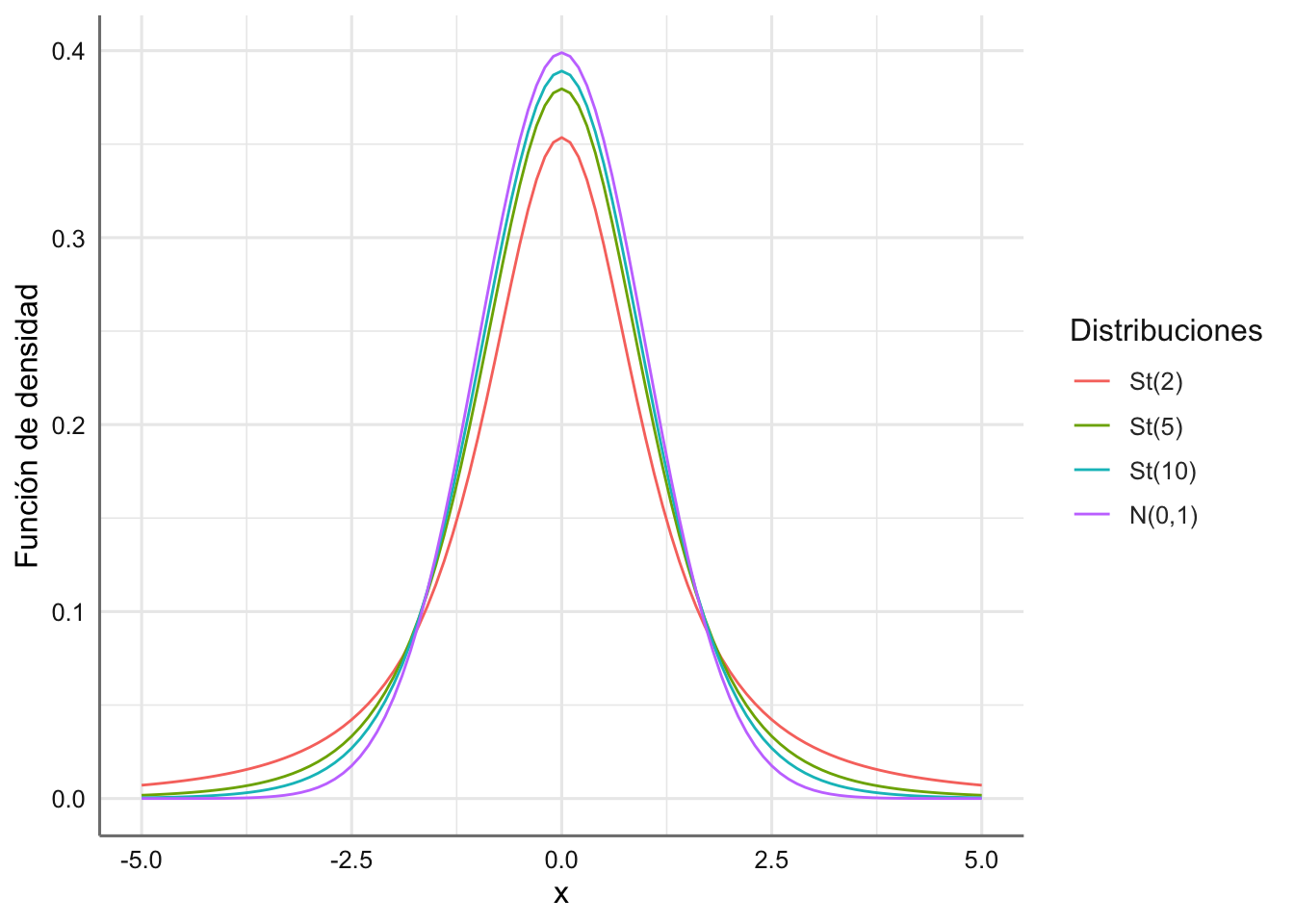

Vinculadas a la distribución Normal surgen las distribuciones \(t\) de Student, Chi-chadrado y \(F\) de Snedecor (también llamada de Fisher-Snedecor), que son ampliamente utilizadas en inferencia estadística. En el último apartado de esta unidad veremos cómo utilizar estas distrbuciones para resolver mediante simulación problemas de intervalos de confianza o contrastes de hipótesis.

Si \(\bar{X_n}=\sum_i X_i/n\) representa la media muestral de \(n\) v.a. \(N(\mu,\sigma)\) y \(S^2=\sum_i(X_i-\bar{X_n})^2/(n-1)\) su varianza muestral, entonces la variable \(Y\) \[ Y= \frac{\bar{X_n}-\mu}{S/\sqrt{n}}\sim St(n-1)\] sigue una distribución t de Student con \(n-1\) grados de libertad, y se denota por \(Y\sim St(n-1)\).

Si tenemos un conjunto de variables normales estándar independientes, \(X_i\sim N(0,1), i=1,\ldots,n\), entonces su suma al cuadrado sigue una distribución chi-cuadrado con \(n\) grados de libertad. \[Z=\sum_{i=1}^n X_i^2 \sim \chi^2_{n}\] Por último, a partir de dos distribuciones chi-cuadrado independientes, \(U\sim \chi^2_n\) y \(V\sim \chi^2_m\), tenemos que su cociente, corregido por sus grados de libertad, sigue una distribución F de Snedecor con \(n\) y \(m\) grados de libertad, \[ W=\frac{U/n}{V/m} \sim F_{(n,m)}.\]

Para la distribución Normal,

- La función

dnorm(x, mean, sd)nos permite evaluar la función de densidad para una variable Normal. -

pnorm(x, mean, sd)calcula la función de distribución. -

rnorm(n, mean, sd)permite generar \(n\) valores de una variable Normal.

Para la distribución t de Student con \(df1\) grados de libertad, las funciones correspondientes son dt(x, df1), pt(x, df1) y rt(n,df1).

Para la distribución chi-cuadrado con \(df1\) grados de libertad, contamos con las funciones dchisq(x,df1), pchisq(x,df1) y rchisq(n,df1) respectivamente.

Para la distribución F de Snedecor con \(df1\) y \(df2\) grados de libertad, tenemos las correspondencias df(x, df1, df2), pf(x, df1, df2) y rf(n,df1,df2).

En la Figura 1.7 aparecen representadas varias distribuciones normales con distinta media y varianza.

x=seq(-10,10,0.1)

y1=dnorm(x)

y2=dnorm(x,0,3)

y3=dnorm(x,2,1)

y4=dnorm(x,2,3)

datos=as.tibble(cbind(x,y1,y2,y3,y4))## Warning: `as.tibble()` was deprecated in tibble 2.0.0.

## Please use `as_tibble()` instead.

## The signature and semantics have changed, see `?as_tibble`.

## This warning is displayed once every 8 hours.

## Call `lifecycle::last_lifecycle_warnings()` to see where this warning was generated.

levels=c("N(0,1)"="y1","N(0,3)"="y2","N(2,1)"="y3","N(2,3)"="y4")

datos=datos %>%

pivot_longer(cols=2:5,names_to="tipo",values_to="valor")

datos$tipo=fct_recode(datos$tipo,!!!levels)

ggplot(datos,aes(x=x,y=valor,color=tipo))+

geom_line()+

labs(color="Distribuciones",y="Función de densidad")

Figura 1.7: Funciones de densidad para varias distribuciones normales.

En la Figura 1.8 aparecen representadas varias distribuciones t de Student con distintos grados de libertad.

x=seq(-5,5,0.1)

y1=dt(x,2)

y2=dt(x,5)

y3=dt(x,10)

y4=dnorm(x)

datos=as.tibble(cbind(x,y1,y2,y3,y4))

levels=c("St(2)"="y1","St(5)"="y2","St(10)"="y3","N(0,1)"="y4")

datos=datos %>%

pivot_longer(cols=2:5,names_to="tipo",values_to="valor")

datos$tipo=fct_recode(datos$tipo,!!!levels)

ggplot(datos,aes(x=x,y=valor,color=tipo))+

geom_line()+

labs(color="Distribuciones",y="Función de densidad")

Figura 1.8: Funciones de densidad para varias distribuciones T de Student.

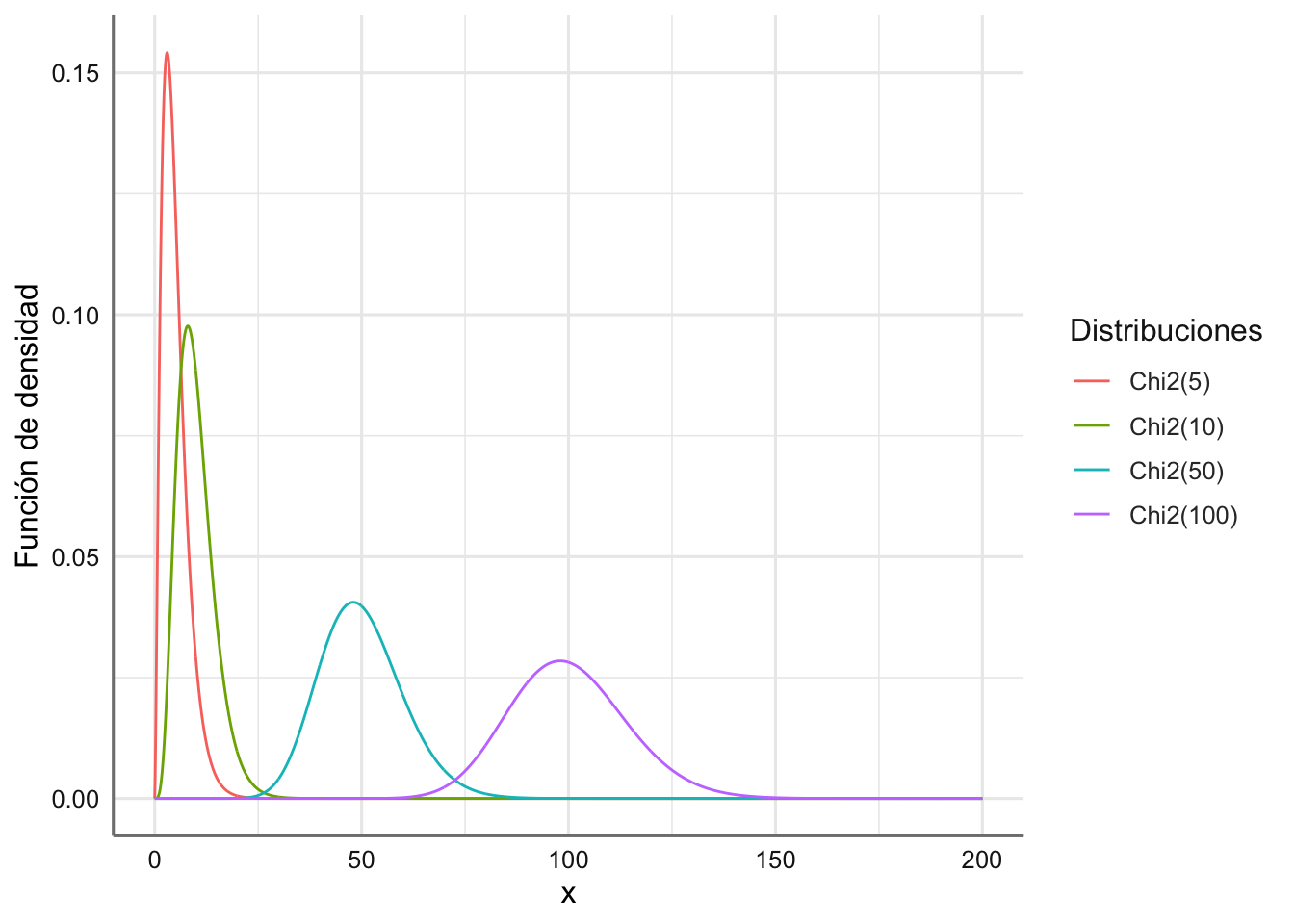

En la Figura 1.9 aparecen representadas varias distribuciones chi-cuadrado con distintos grados de libertad.

x=seq(0,200,0.1)

y1=dchisq(x,5)

y2=dchisq(x,10)

y3=dchisq(x,50)

y4=dchisq(x,100)

datos=as.tibble(cbind(x,y1,y2,y3,y4))

levels=c("Chi2(5)"="y1","Chi2(10)"="y2","Chi2(50)"="y3","Chi2(100)"="y4")

datos=datos %>%

pivot_longer(cols=2:5,names_to="tipo",values_to="valor")

datos$tipo=fct_recode(datos$tipo,!!!levels)

ggplot(datos,aes(x=x,y=valor,color=tipo))+

geom_line()+

labs(color="Distribuciones",y="Función de densidad")

Figura 1.9: Funciones de densidad para varias distribuciones Chi-cuadrado.

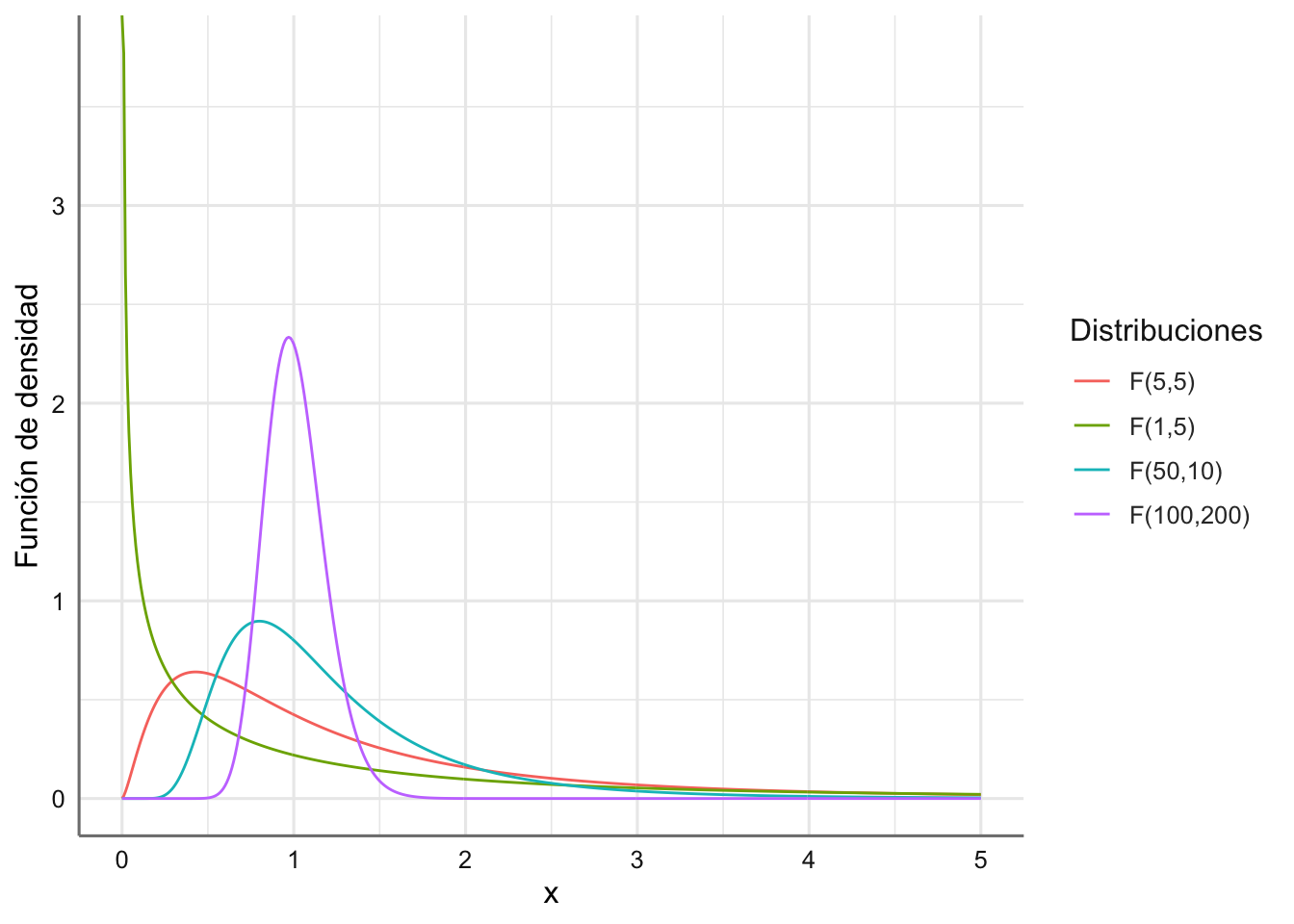

En la Figura 1.10 aparecen representadas varias distribuciones F de Snedecor con distintos grados de libertad.

x=seq(0,5,0.01)

y1=df(x,5,5)

y2=df(x,1,5)

y3=df(x,50,10)

y4=df(x,100,200)

datos=as.tibble(cbind(x,y1,y2,y3,y4))

levels=c("F(5,5)"="y1","F(1,5)"="y2","F(50,10)"="y3","F(100,200)"="y4")

datos=datos %>%

pivot_longer(cols=2:5,names_to="tipo",values_to="valor")

datos$tipo=fct_recode(datos$tipo,!!!levels)

ggplot(datos,aes(x=x,y=valor,color=tipo))+

geom_line()+

labs(color="Distribuciones",y="Función de densidad")

Figura 1.10: Funciones de densidad para varias distribuciones F-Snedecor.

1.5 Simular con la Transformada Inversa

Aunque las distribuciones estudiadas en el punto anterior, al ser habituales provocan que los algoritmos de simulación y sus funciones de probabilidad ya estén implementadas en la mayoría de los paquetes estadísticos y de cálculo, en otras ocasiones, ante otras distribuciones menos comunes, no disponemos de un método directo para la simulación de muestras aleatorias, y necesitamos recurrir a algoritmos genéricos de simulación de variables.

Presentamos a continuación un algoritmo genérico para simular de variables discretas o continuas definidas a trozos: el algoritmo de la transformada inversa, que pasamos a describir, tanto para variables continuas como para variables discretas.

Definición 1.18 Algoritmo de la transformada inversa para variables continuas

Dada una variable aleatoria \(X\) de tipo continuo, cuya función de distribución viene dada por \(F(x)\), y cuya función de distribución inversa se denota por \(F^{-1}(x)\), el algoritmo de la transformada inversa permite obtener una muestra de tamaño \(n\) de la variable \(X\) mediante el siguiente procedimiento:

- Generar \(n\) valores uniformes en el intervalo \([0,1]\),

\[u_i\sim U(0,1), \quad i=1,...,n\]

- Devolver \(x_i = F^{-1}(u_i)\).

Así los valores \(\{x_1,...,x_n\}\) constituyen una muestra de \(X\).

El algoritmo es conceptualmente similar para variables discretas, si bien por la discretización, varía levemente.

Definición 1.19 Algoritmo de la transformada inversa para variables discretas

Dada una variable aleatoria \(X\), de tipo discreto, con \(k\) posibles valores diferentes \(x_1,...,x_k\), y cuya función de distribución viene dada por:

\[F(x) = Pr(X \leq x) = \sum_{x_i \leq x} Pr(X = x_i), i=1,...,k,\]

el algoritmo de la transformada inversa permite obtener una muestra de tamaño \(n\) de la variable \(X\) mediante el siguiente procedimiento:

- Generar \(n\) valores uniformes en el intervalo \([0,1]\), \[u_i\sim U(0,1), \quad i=1,...,n\]

- Para cada \(u_i\) generado se determina el entero \(I\) más pequeño que satisface \(u_i \leq F(x_I)\), del conjunto \(\{x_1,...,x_k\}\)

- Devolver \(x_I\) para cada valor simulado.

Así los valores \(\{x_1,...,x_n\}\) constituyen una muestra de \(X\).

En los puntos siguientes vamos a mostrar el uso de los algoritmos 1.18 y 1.19 en diferentes ejemplos de variables de tipo discreto y continuo.

1.6 Otras distribuciones discretas

Analizamos diferentes ejemplos en los que estamos interesados en evaluar un sistema que involucra a una o más variables de tipo discreto, y donde únicamente disponemos de información sobre la función de masa de probabilidad o sobre la función de distribución.

1.6.1 Una variable discreta

Supongamos un sistema en el que contamos con información de una única variable discreta de interés que deseamos estudiar. En los casos más sencillos que tratamos aquí, las situaciones planteadas se pueden resolver teóricamente sin mucha dificultad, pero el objetivo es mostrar el uso de la simulación para llegar a resultados aproximados a los que proporcionan los métodos análiticos.

Ejemplo 1.12 Una empresa que fabrica piezas para maquinaria de fabricación de calzado tiene diseñada la cadena de producción de tal forma que las piezas fabricadas se almacenan (y venden) en cajas de dos unidades. El beneficio estimado de una caja sin defectos es de 300 euros. La política de la empresa establece que si al servir una caja a los clientes, esta contiene una pieza defectuosa, debe ser devuelta de forma inmediata para su reemplazo, lo que supone una pérdida de 50 euros por pieza defectuosa (y la devolución de los 300 euros de beneficio por la venta). El problema es que una vez cerradas las cajas en la cadena de producción no se inspeccionan para estimar el número de cajas que se podrían devolver. La única información disponible hace referencia a la tasa de defectos observada en cada caja cuando esta es devuelta, junto con el porcentaje de cajas que son devueltas. En base a esta información, si \(N\) refleja el número de piezas defectuosas observadas, la empresa ha establecido que:

\[\begin{equation} Pr(N = k) = \begin{cases} 0.82 & \text{ para } k = 0\\ 0.15 & \text{ para } k = 1\\ 0.03 & \text{ para } k = 2\\ \end{cases} \tag{1.20} \end{equation}\]

La empresa quiere estudiar el beneficio estimado de acuerdo a la politica de producción actual para el próximo mes, sabiendo que se pueden llegar a producir hasta 1500 cajas en ese periodo. Además la empresa está interesada en conocer el beneficio estimado si cambiara su politica de calidad reduciendo su tasa de defectos por caja de acuerdo a las siguientes proporciones:

\[\begin{equation} Pr(N = k) = \begin{cases} 0.85 & \text{ para } k = 0\\ 0.13 & \text{ para } k = 1\\ 0.02 & \text{ para } k = 2\\ \end{cases} \tag{1.21} \end{equation}\]

Para resolver las inquietudes de la empresa, vamos a simular el proceso en las dos situaciones planteadas, para el horizonte propuesto de un mes, esto es, simulando las 1500 cajas y estimando el beneficio obtenido de acuerdo a las políticas de calidad dadas en (1.20) y (1.21).

Proponemos el siguiente algoritmo de simulación para obtener la ganancia asociada a cada una de las políticas de calidad, y con dichas ganancias compararlas y concluir cuál es la más beneficiosa.

Algoritmo de simulación Ante una política de calidad:

- Fijar las condiciones de simulación: nº cajas (\(nsim = 1500\)).

- Obtener las función de distribución acumulada vinculada con la politica de calidad de interés y aplicar el algoritmo dado en al definición 1.19 para obtener una muestra de \(N\), \(x_1,...,x_n\), relativas al número de piezas defectuosas en cada caja.

- Calcular el beneficio obtenido para cada caja, vinculado a cada valor \(x_i\), denominado \(b_i\).

- Obtener la ganancia global con todas las cajas simuladas como:

\[G = \sum_{i=1}^n b_i\]

Lancemos el algoritmo para cada situación y obtengamos los beneficios esperados.

# Parámetros de la simulación

set.seed(19)

nsim <- 1500

# datos uniformes

unif <- runif(nsim)

# Valores a devolver (piezas defectuosas por caja)

valores <- c(0, 1, 2)

# Valores a devolver y probabilidad acumulada para la política 1

prob1 <- c(0.82, 0.15, 0.03)

probacum1 <- cumsum(prob1)

# Valores a devolver y probabilidad acumulada para la política 2

prob2 <- c(0.85, 0.13, 0.02)

probacum2 <- cumsum(prob2)

# Inicialización de variables donde almacenamos las simulaciones

xs1 <- c(); benef1 <- c()

xs2 <- c(); benef2 <- c()

# Simulación de la variable de interés

i <- 1

while (i <= nsim)

{

# politica 1

xs1[i] <- valores[min(which(unif[i] <= probacum1))]

benef1[i] <- ifelse(xs1[i]==0, 300, -50*xs1[i]) # beneficios

# politica 2

xs2[i] <- valores[min(which(unif[i] <= probacum2))]

benef2[i] <- ifelse(xs2[i]==0, 300, -50*xs2[i])

# nueva simulación

i <- i+1

}

# Resultados para las nsim simulaciones

simulacion <- data.frame(defec.s1 = xs1, benef.s1 = benef1,

defec.s2 = xs2, benef.s2 = benef2)

cat("Una muestra de las simulaciones realizadas es ...\n")## Una muestra de las simulaciones realizadas es ...

head(simulacion)## defec.s1 benef.s1 defec.s2 benef.s2

## 1 0 300 0 300

## 2 0 300 0 300

## 3 0 300 0 300

## 4 0 300 0 300

## 5 0 300 0 300

## 6 0 300 0 300

# Rendimientos globales

beneficios=simulacion %>%

summarise(G1 = sum(benef.s1), G2 = sum(benef.s2),

Dif = G2 - G1)

cat("Beneficios S1 (€):",beneficios$G1,

"Beneficios S2 (€):",beneficios$G2,

"Diferencia S2-S1 (€):",beneficios$Dif)## Beneficios S1 (€): 350950 Beneficios S2 (€): 367200 Diferencia S2-S1 (€): 16250En consecuencia, se aprecia cómo una leve mejora de la calidad en la producción (reduciendo la tasa de defectos) proporciona a la empresa una ganancia sustancial, por lo que la política S2 sin duda es la más ventajosa para su negocio.

Ejemplo 1.13 Una empresa de inversiones está considerando tres nuevos planes de inversión. Cada plan requiere una inversión de 25.000 dólares y el retorno será un año después. El plan A retornará de forma fija 27.500 dólares. El plan B retornará 27.000 dólares o 28.000 dólares, con probabilidades 0.4 y 0.6, respectivamente. El plan C retornará 24.000, 27.000 o 33.000 dólares con probabilidades de 0.2, 0.5 y 0.3, respectivamente. Si el objetivo de la empresa es maximizar el rendimiento esperado, ¿qué plan debería elegir?

Hay que tener en cuenta que en este caso no sólo es relevante el rendimiento esperado, sino también la volatilidad esperada para ese beneficio, expresada en términos de variabilidad o incertidumbre. Será pues interesante, calcular el rendimiento o el retorno esperado en cada situación, además de su varianza o desviación típica.

Vamos a plantear un proceso de simulación para estimar los beneficios y volatilidad asociadas a cada plan. Fijaremos el mismo número de simulaciones en cada plan, con el fin de hacer comparables los resultados. El algoritmo se presenta a continuación.

Algoritmo de simulación

- Fijar condiciones de simulación (\(nsim = 1000\))

- Obtener la función de distribución acumulada vinculada con cada uno de los planes de inversión y aplicar el algoritmo dado en la definición 1.19 para obtener una muestra de cada uno de ellos.

- Calcular el beneficio obtenido para cada simulación en cada plan.

- Obtener la ganancia estimada de cada plan como la media de los beneficios obtenidos para cada simulación, y la volatilidad como la desviación típica de los beneficios obtenidos.

Y procedemos con la simulación, calculando el beneficio esperado y la desviación típica en cada plan de inversión. Considerando que el plan A no tiene incertidumbre alguna (Varianza=0) y el beneficio fijo que generará será de $2500, no lo incluimos en la simulación.

# Parámetros de la simulación

set.seed(1970)

nsim <- 1000

# datos uniformes

unif <- runif(nsim)

# Beneficios asociados a cada plan

BpB <- c(2000, 3000) # beneficio variable

BpC <- c(-1000, 2000, 8000) # beneficio variable

# Distribuciones de probabilidiad para los planes B y C

probB <- c(0.4, 0.6)

probacumB <- cumsum(probB) # función de distribución plan B

probC <- c(0.2, 0.5, 0.3)

probacumC <- cumsum(probC) # función de distribución plan

# Inicialización de variables donde almacenamos las beneficios

# individuales para cada simulación

benefB <- c()

benefC <- c()

# Simulación de la variable de interés

i <- 1

while (i <= nsim)

{

# plan B

benefB[i] <- BpB[min(which(unif[i] <= probacumB))]

# plan C

benefC[i] <- BpC[min(which(unif[i] <= probacumC))]

# nueva simulación

i <- i+1

}

# Resultado

simulacion <- data.frame(A=rep(2500,nsim),B = benefB, C = benefC)

cat("Una muestra de las simulaciones realizadas es ...\n")## Una muestra de las simulaciones realizadas es ...

head(simulacion)## A B C

## 1 2500 2000 -1000

## 2 2500 3000 8000

## 3 2500 2000 -1000

## 4 2500 2000 -1000

## 5 2500 3000 8000

## 6 2500 3000 8000

beneficios=simulacion %>%

summarise(mPB = mean(B), sdPB = sd(B),

mPC = mean(C), sdPC = sd(C))

cat("Beneficios PlanA ($):",2500,

"Volatilidad (sd):",0,

"Beneficios PlanB ($):",beneficios$mPB,

"Volatilidad (sd):",beneficios$sdPB,

"Beneficios PlanC ($):",beneficios$mPC,

"Volatilidad (sd):",beneficios$sdPC)## Beneficios PlanA ($): 2500 Volatilidad (sd): 0 Beneficios PlanB ($): 2604 Volatilidad (sd): 489.3091 Beneficios PlanC ($): 3122 Volatilidad (sd): 3315.435Podemos ver que aunque el plan C es el que proporcioanrá más retorno esperado, también es el que tiene una mayor volatilidad (sd), lo que produce incertidumbre y podría repercutir en una mayor pérdida al final del periodo de inversión. El plan A tiene un beneficio fijo sin volatilidad ninguna, pero es inferior al beneficio del plan B. A efetos estadísticos, ya que la volatilidad (desviación típica) del plan B toma un valor inferior a la media, el coeficiente de variación (\(cv=sd/media\)) resulta inferior a 1, y en consecuencia da una alternativa razonable al plan A. Por contra, no ocurre así en el plan C (\(cv>1\)) lo que lo coloca en una situación de inferioridad frente a los otros planes de inversión.

Con el fin de afinar en nuestra comparación de los tres planes de inversión, no nos vamos a conformar con valores esperados y desviaciones típicas, y vamos a calcular la probabilidad de que beneficio obtenido sea mayor a 2500 dólares con cada plan, cálculo que podemos resolver fácilmente a partir de las simulaciones obtenidas.

# Probabilidad beneficio > 2500

c(prA = sum(simulacion$A>2500)/1000,

prB = sum(simulacion$B>2500)/1000,

prC = sum(simulacion$C>2500)/1000)## prA prB prC

## 0.000 0.604 0.289Con este cálculo, el plan B sale claramente reforzado, con una probabilidad destacable de generar un beneficio superior a $2500 (prob=0.6), frente al plan A (prob=0) y al C (prob=0.29). El plan A no puede superar unos rendimientos superiores a 2500, al ser este valor su fijo.

1.6.2 Mixturas de Discretas

Estas situaciones son muy habituales e involucran la combinación de diferentes variables de tipo discreto en un mismo sistema, en lo que se viene a denominar mixtura de variables aleatorias de tipo discreto o modelos secuenciales. Sobre este tipo de distribuciones resulta bastante sencillo plantear un algoritmo de simulación. Antes de comenzar veamos desde un punto de vista téorico el concepto de mixtura de variables.

Definición 1.20 Sean \(X_1, X_2,...,X_n\) un conjunto de variables aleatorias independientes de tipo discreto y sea \(I\) una variable indicador de tipo discreto, definida en los valores \(\{1,..., n\}\), tal que \[Pr(I=j)=p_j, j=1,..., n, \quad \sum_{j=1}^n p_j = 1.\]

La variable aleatoria \(T\) que se define como:

\[ T = \sum_{j =1}^n p_j X_j\]

se denomina mixtura del conjunto \(X_1,...,X_n\) con índice \(I\), y además cumple que:

\[E(T) = \sum_{j=1}^n p_j E(X_j)\]

\[E(T^2) = \sum_{j=1}^n p_j (V(X_j) + E(X_j)^2).\]

Así, la varianza de \(T\) se puede calcular fácilmente a partir de la expresión:

\[V(T) = E(T^2) - E(T)^2\]

El algoritmo para simular de una mixtura es bastante sencillo y se basa en la aplicación consecutiva en dos pasos del algoritmo de la transformada inversa para variables discretas en la Definición 1.19.

Definición 1.20 Algoritmo simulación mixtura variables discretas

En la situación descrita en la definición 1.20 el algoritmo para generar una muestra de la mixtura debe proporcioanr en cada simulación un vector de dos componentes: variable seleccionada (\(I\)) y valor generado de \(X_I\). En concreto:

- Paso 1. Establecer el tamaño de muestra a simular \(nsim\).

Repetir los pasos 2 y 3 para cada iteración \(i\) de \(1, 2,..., nsim\):

Paso 2. Simular un valor para el indicador \(I_i\) de la variable de mixtura, mediante el algoritmo de la transformada inversa para una variable discreta (Definición 1.19) con probabilidades \(p_1,...,p_n\), y seleccionar la variable \(X_{I_i}\) para dicho indicador.

Paso 3. Simular un valor \(x_{I_i}\) mediante el algoritmo de la transformada inversa para \(X_i\).

Paso 4. Devolver el conjunto de simulaciones \(\{I_i, x_{I_i}\}_{i=1}^{nsim}.\)

Pasamos a estudiar un par de ejemplos de situaciones secuenciales para variables discretas que se pueden modelizar según una mixtura y donde podemos aplicar el algoritmo anterior.

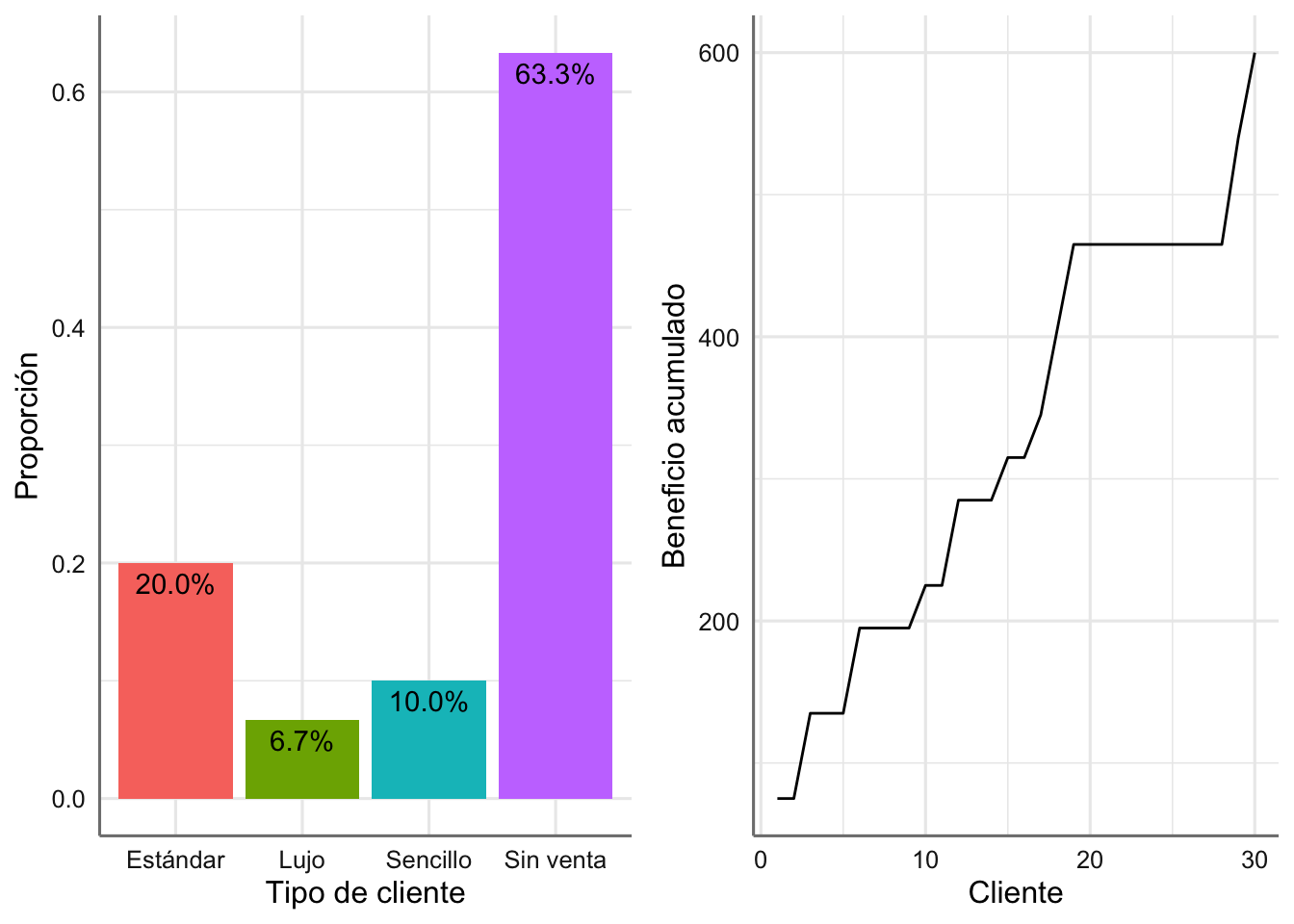

Ejemplo 1.14 Una tienda de electrodomésticos desea analizar las ventas de hornos microondas. Los gerentes de la tienda saben que en muchas ocasiones la gente entra en la tienda simplemente para curiosear, pero de todas las personas con intenciones claras de compra, el 50% acaba comprando uno de los tres modelos disponibles y el otro 50% finalmente no realiza ninguna compra. De los clientes que compran un horno, el 25% adquiere el modelo sencillo, el 50% el modelo estándar y el 25% el modelo de lujo. El modelo sencillo produce una ganancia de 30 dólares; el modelo estándar produce una ganancia de 60 dólares y el modelo de lujo produce una ganancia de 75 dólares.

Los gerentes están interesados en estimar el beneficio medio por cliente de todos aquellos con intención de comprar, y que por tanto utilizan el asesoramiento (y tiempo) de los vendedores.